杜麟,田畅,吴泽民,张兆丰,胡磊,张磊

(中国人民解放军理工大学 通信工程学院,江苏 南京 210007)

摘要:Q-STAR模型是现有的客观视频质量评价中最接近主观得分的模型,但是在解码端难以从丢包解码后的YUV视频序列中提取与编码端相一致的运动矢量信息,从而影响模型参数的预测。针对该问题,提出了基于视敏度信息的模型参数预测方法,从YUV视频序列中提取时间域和空间域视敏度特征,并结合Q-STAR模型中提取的特征进行预测。通过实验发现,使用视敏度信息代替原有的运动矢量信息进行预测,所得模型参数值与Q-STAR基本相符,并且计算更为简单。

中图分类号:TN919.85文献标识码:ADOI: 10.19358/j.issn.1674-7720.2017.01.013

引用格式:杜麟,田畅,吴泽民,等. 基于视敏度的QSTAR模型参数预测[J].微型机与应用,2017,36(1):40-43.

0引言

视频传输质量保障的最终目的是保障接收端视频的服务质量,首先需要建立与人的主观感受相一致的视频质量评价模型。近年来,越来越多的研究着力于建立符合人眼视觉感知特性的评价指标[12]。常见的方法是对主观评价结果进行分析,并建立相应的模型使得评价的结果逼近真实主观评价的结果。文献[34]首先从时间域和质量域出发,分别研究了帧率以及量化步长对主观感知和码率的影响,随后在文献[5]中加入分辨率对主观感受的影响,并提出了联合模型QSTAR。文献[6]中提出用视敏度评估视频质量,用相邻的视频帧之间像素之差表示时间信息,用源视频与测试视频的时间信息差异表示视频的损伤,并通过回归树的方法估计主观得分。

本文从YUV视频序列中提取时间域和空间域视敏度信息作为新的特征值,并进行模型参数的预测。

1Q-STAR模型

文献[5]从质量域、时间域以及空间域三个方向出发,分别研究了量化步长、帧率以及分辨率对视频主观感知质量的影响,从而得到了联合的视频主观感知模型QSTAR,模型的计算表达式以及参数预测如下所示:

其中,q、f、s分别代表视频的量化步长、帧率以及分辨率;βq、βf、βs、v1和v2是与视频内容无关的常数;αq、αf和s则是与视频内容有关的参数,分别表示随着量化步长、帧率以及分辨率的变化,视频主观感知质量变化的快慢;σDFD为基于运动估计的相邻两帧之间帧差均值的标准差;μFD为相邻两帧之间帧差均值的平均,σ为各帧像素值标准差的均值,η(μFD,σ)=μFD/σ;Gm为各帧Gabor滤波输出值均值的平均;H为3×4的预测系数矩阵。

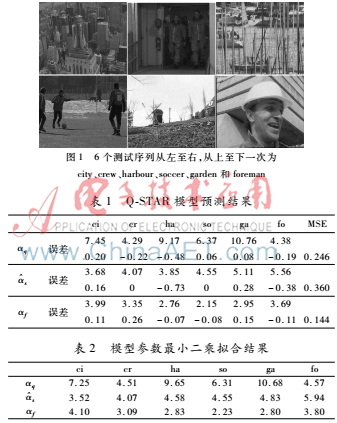

使用QSTAR模型对6个视频序列(city、crew、harbour、soccer、garden和foreman)进行参数预测。图1为6个视频序列的简图。预测的结果如表1所示。表2表示用最小二乘拟合对主观得分进行拟合得到的模型参数值,将该数值作为模型参数预测的真实值,用于评价参数预测的好坏。(表格中视频序列取前两个字母表示)。

对表1中的结果进行分析可以发现,对于运动剧烈和场景复杂的视频序列来说,QSTAR模型参数的预测存在较大的误差,分析原因在于模型参数的预测中使用了特征σDFD,而σDFD是基于运动估计的相邻两帧之间帧差均值的标准差。对于运动剧烈和场景复杂的视频序列来说,运动矢量信息以及残差信息远大于其他的视频序列,难以进行准确的运动估计,运动估计的不准确性导致运动补偿之后的误差增大,使得特征σDFD计算不准确,从而造成模型参数预测的误差。另一方面,运动矢量信息需要从264码流中提取,无法直接从YUV视频序列中得到,在视频传输过程中如果发生丢包,解码后的视频能难得到有效的运动矢量信息,因此,该预测只能用于编码端或者是无丢包条件下的视频质量评价。为了解决以上问题,本文提出了一种基于视敏度的参数预测方法。

2视敏度

文献[6]将视敏度[78]定义为视频的感知质量,并给出了一种在线计算视敏度的方法。视敏度是最基本的人眼视觉系统(Human Visual System,HVS)视觉处理机制,它表征了HVS对不同频率视觉信号的响应强度,主要有时域对比敏感度和空域对比敏感度。

时域对比敏感度主要反映了视频序列受帧率的影响,表现在视频序列的连贯性上,体现了帧与帧之间的差别。图2分别表示同一视频在帧率为3.75、7.5、15以及30时相同位置连续的5帧。从图2可以看出帧率越大,帧与帧之间的差别较小,视频序列的连贯性越好;而帧率越小,帧与帧之间差别较大,造成视频序列的不连贯,出现“跳跃”的现象。

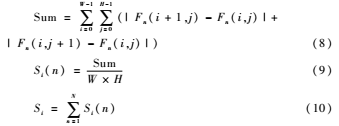

用时域信息Ti表示时域对比敏感度,Ti的计算表达式如下:

![$6PV2GUXS]B(J65F4[UO2UO.png $6PV2GUXS]B(J65F4[UO2UO.png](http://files.chinaaet.com/images/2017/03/02/6362407312001246987636652.png)

其中H和W分别代表视频的高度和宽度;c代表颜色深度;Fn(i,j)代表视频第n帧图像中位于位置(i,j)的像素值;N代表视频的帧数。

空域对比敏感度主要受分辨率影响,体现在视频序列的尺寸上,图3分别表示了同一视频在两种分辨率下相同位置的帧。从图3中可以看出分辨率越大,人眼的主观感受越好;分辨率越小,越容易造成主观感受的下降。

用空域信息Si表示空域对比敏感度,Si的计算表达式如下:

为了解决模型参数预测中运动矢量信息的问题,分别计算了源视频时域信息Tio以及空域信息Sio和测试视频的时域信息Tit以及空域信息Sit,并把时域信息和空域信息的变化DTi和DSi作为新的特征,特征计算如下:

![}5LJ%]4PXX%[}V594N}CC5Y.png }5LJ%]4PXX%[}V594N}CC5Y.png](http://files.chinaaet.com/images/2017/03/02/6362407314276413266419741.png)

3模型参数预测

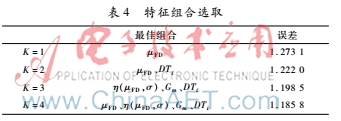

为了用尽可能少的特征组合进行模型参数的预测,本文采用文献[5]所用的交叉验证法验证各个特征对模型参数的影响。从视频序列提取的特征如表3所示。交叉验证法的基本思想是每次实验随机选取一个视频序列做为测试序列,其余的视频序列用于训练,记P⌒=[α⌒s,αf,αq]T、F=[1,f1,f2,…,fK]T,则预测方程为=HF,其中K为选择特征的个数。从K=1开始,选择不同的特征使得拟合误差∑mm-Pm2最小,其中m为训练视频序列的个数。逐渐增大K值直到拟合误差没有显著的变化为止,从而得到最佳的特征组合F和预测矩阵H。表3视频特征描述特征符号表示FDμFDSTDσNFDη(μFD,σ)=μFD/σGaborGmTiDTiSiDSi从6个视频序列中选取5个用于训练,剩下一个视频序列用于测试,求取预测结果与最小二乘拟合值之间的误差,通过误差大小进行特征组合的选取,表4表示了不同个数特征组合下最佳的特征组合以及其最小误差。

通过表4可以看出,当K=4时误差最小,而K=3时的误差与K=4时仅相差0.013,因此,选择DTi、η(μFD,σ)和Gm三种特征进行模型参数的预测,预测方程如式(12)所示。

![1F~%N({0Q13G]X38N93BWE0.png 1F~%N({0Q13G]X38N93BWE0.png](http://files.chinaaet.com/images/2017/03/02/6362407316195304076501961.png)

4实验结果

实验仿真平台为MATLAB 2010b。对city、crew、harbour、soccer、garden和foreman 6个视频进行测试。本文采用H.264编码标准进行编码,编码的结构为IPPP,GOP长度为25,QP取值为28、32、36、40和44,帧率取值为3.75、7.5、15和30。在视频传输过程中分辨率通常保持不变,因此,实验中选取标准视频库中352×288的视频序列进行测试,并将QP为28、帧率为30的编码视频序列作为学习的视频序列,从该学习视频序列中提取所需要的特征进行模型参数的预测。预测结果如表5所示。由于不考虑分辨率的变化,因此也不考虑模型参数s的预测结果。重点比较模型参数αq,通过对表1、表2和表5的分析可以看出,在对模型参数αq的预测中,本文提出的预测方法普遍优于QSTAR的预测结果。而在对模型参数αf的预测中,发现对于运动剧烈和场景复杂的视频序列,如harbour、soccer,本文提出的预测方法比QSTAR的预测结果更优,但是对于运动平缓和场景简单的视频序列,如crew和garden而言,本文提出的预测方法比QSTAR的预测结果稍差,原因在于对于此类视频,运动估计较为准确,运动补偿之后得到的特征σDFD更准确,所以预测的结果更接近于最小二乘拟合的结果。在传输过程中,通常采用固定的帧率,且帧率大于15 fps,视频主观感知质量受QP的影响最大,并且QSTAR模型的预测需要从264码流提取运动矢量信息,而本文提出的基于视敏度的QSTAR模型利用视敏度信息代替运动矢量信息能达到相同的效果,误差在可接受范围内,因此,本文提出的方法更优。

5结论

网络视频应用越来越普及,保障用户的体验是首要目的,基于PSNR的端到端失真估计保护以最小化失真为目标,如文献[9]。而人眼视觉系统的复杂性决定了该保护与人眼感知的差异,基于主观感知评价的视频传输保障成为近年来研究的热点。本文基于视敏度对现有的主观感知模型QSTAR中模型参数进行了重新预测,提高了模型参数αq的预测准确度,并解决了运动剧烈和场景复杂的视频序列中模型参数s和αf预测误差较大的问题,但是对于运动平缓和场景简单的视频序列中模型参数的预测准确度有待提高。同时,模型参数的预测所需的视频特征仅仅通过YUV视频序列本身进行提取,不需要相应的264码流,在传输分组丢失的情况下,接收端无需重新估计运动矢量信息,在尽可能保障模型参数预测准确度的同时使得计算更为简单,可有效地用于视频质量评价和视频传输端到端的保障。

参考文献

[1] 蒋刚毅, 朱亚培, 郁梅, 等. 基于感知的视频编码方法综述[J]. 电子与信息学报, 2013, 35(2): 474-483.

[2] LEE J, EBRAHIMI T. Perceptual video compression: a survey[J]. IEEE Journal of Selected Topics in Signal Processing, 2012, 6(6): 684-697.

[3] OU Y F, MA Z, LIU T, et al. Perceptual quality assessment of video considering both frame rate and quantization artifacts[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2011, 21(3): 286-298.

[4] MA Z, XU M, OU Y F, et al. Modeling of rate and perceptual quality of compressed video as functions of frame rate and quantization stepsize and its applications[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2012, 22(5): 671-682.

[5] OU Y F, XUE Y, WANG Y. QSTAR: a perceptual video quality model considering impact of spatial, temporal, and amplitude resolutions[J]. IEEE Transactions on Image Processing, 2014, 23(6): 2473-2486.

[6] BAIK E, PANDE A, STOVER C, MOHAPATRA P. Video acuity assessment in mobile devices[C]. 2015 IEEE Conference in Computer Communications (INFOCOM), HONG KONG, 2015: 19.

[7] LIN W, KUO C C J. Perceptual visual quality metrics: a survey[J]. Journal of Visual Communication & Image Representation, 2011, 22(4):297-312.

[8] BALACHANDRAN A, SEKAR V, AKELLA A, et al. Developing a predictive model of quality of experience for internet video[J]. ACM SIGCOMM Computer Communication Review, 2013, 43(4): 339-350.

[9] LI C, XIONG H, WU D. Delayratedistortion optimized rate control for endtoend video communication over wireless channels[J]. IEEE Transactions on Circuits & Systems for Video Technology, 2015, 25(10):1665-1681.