入门:浅谈智驾系统的摄像头前端感知模组相关技术参数

2022-12-24

来源:焉知智能汽车

从主机厂的自动驾驶技术搭载情况来看,其感知技术方案大致可分为两类:一种是基于视觉的自动驾驶系统,另一种是基于雷达+视觉的自动驾驶系统。后者主要使用雷达传感器来检测物体,而视觉系统则完全基于摄像头。从当初传统的TIer1(如博世、大陆等)倾向于搭载简单低成本的毫米波雷达系统用于实现基础的辅助驾驶功能。而诸如特斯拉这类高尖端的主机厂更是从最初的视觉方案到后面引入雷达传感器,再到放弃雷达回归纯视觉方案,经历了多次反复。包括国内很多主机厂也将很大程度的研发精力放在了对视觉感知上。通过利用计算机视觉系统检测、识别物体,利用不同的神经网络模型检测不同的对象模型,一旦判断失误,就会导致事故。基于视觉的自动驾驶系统需要强大的软件算法能力,以及大量数据对AI模型的长期训练。这显然不是一朝一夕可以实现的。

然而,除了感知软件这一难题外,我们对于感知前端的摄像头硬件模组又了解多少呢?本文将系统的介绍摄像头前端感知模组的相关技术参数及评价指标。

摄像头模组相关选型介绍

摄像头模组CCM主要由镜头(lens)、镜座、红外滤光片(IR Filter)、传感器(Sensor)、PCB板、FPC柔性电路板等结构组成,是影像捕捉至关重要的电子器件。

基本原理是通过外部光线照射在物体上,经过反射、折射后穿过镜头(Lens),再经过滤光片滤波投射到图像传感器(Sensor)感光面上。其基础原理是通过Sensor将Lens上传导过来的光线转换为电信号,经过内部图像处理器(ISP)转换成数字图像信号输出到数字信号处理器(DSP)加工处理,转换成标准的GRB、YUV等格式图像信号。若Sensor内部未集成ISP,则通过DVP的方式传输到图像处理器,此时的数据格式为RAW RGB(原始数据)。

1)镜头(lens)

镜头相当于人眼中的晶状体,利用透镜的折射原理,景物光线透过镜头在聚焦平面上形成清晰的像。Camera的镜头结构一般是有几片透镜组成的,透镜分为塑胶透镜(PlasTIc)以及玻璃透镜(Glass),常用的镜头结构有:1P、2P、1G1P、1G3P、2G2P等。

透镜越多,成本越高,成像效果也越好(光线更均匀、更细致;对光线的选通更丰富;成像畸变更小,但是会导致镜头变长,光通量变小),玻璃透镜的透光率、感光性比塑胶透镜的要好,但价格也更贵。

镜头的关键指标就是镜头的焦距,通常根据镜头焦距的不同,进行不同的分类。镜头的焦距决定了该镜头拍摄的物体在Sensor上所形成影像的大小,焦距越短,拍摄范围就越大,也就越接近广角镜头;焦距越长,镜头的视角越小,拍摄到景物的范围也就越小,也就越接近窄角摄像头。通常会把短焦距、视场角大于50°(如f=3mm左右)的镜头,称为广角镜头,如前视120°摄像头;把更短焦距(如f=2.8mm)的镜头叫走超广角镜头,如环视摄像头;而把焦距很长(如f>80mm)的镜头称为望远镜头,如智驾域经常用到的30°远摄摄像头。介于短焦与长焦之间的镜头就叫做标准镜头,如智驾域的侧视摄像头。

镜头的焦距、视场大小及镜头到被摄取物体的距离计算公式如下:

f = w*D / W f = h*D / H

其中:f—镜头焦距,w—图像的宽度(被摄物体在Sensor靶面上的成像宽度),W—被摄物体宽度,D—被摄物体距离镜头的距离,h—图像高度(被摄物体在Sensor靶面上的成像高度),H—被摄物体的高度。

镜头尺寸

一般可分为25.4mm(1inch)、16.9mm(2/3inch) 、12.7mm(1/2inch) 、 8.47mm(1/3inch)和 6.35mm(1/4inch)等几种规格 。选用镜头时,应使镜头尺寸与摄像机的靶面尺寸大小相吻合,并注意这样一个原则,即小尺寸靶面的图像Sensor可使用大尺寸的镜头,反之则不行。如1/2“的Sensor采用1/3”的镜头,则进光量会变小,色彩会变差,甚至图像也会缺损;反之,则进光量会变大,色彩会变好。

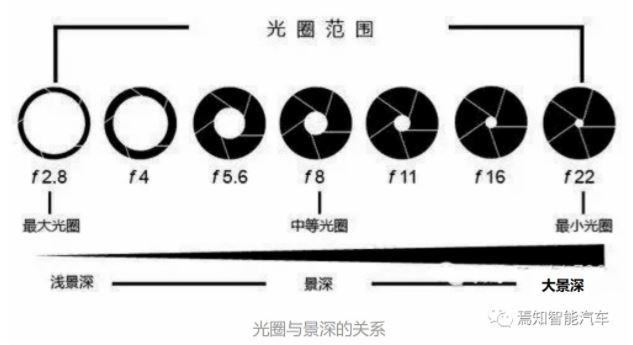

此外,我们还比较关心的是镜头通光孔径大小对镜头的影响。通常,通光孔径越大,通过的光量越大,但我们关心的是到达Sensor的光量。焦距越长,意味着Sensor离镜头中心越远,相应的光就越弱,所以,标准光圈大小的参数应该与两个变量有关:即孔径,焦距。

可以定义光圈的相对孔径等于镜头的有效孔径与镜头焦距之比,镜头的相对孔径表征了镜头的通光能力,相对孔径越大,通光越多。

光圈系数F = 焦距(f) / 镜头有效孔径 (D)

光圈相对孔径 = 镜头有效孔径 (D) / 焦距(f)

即F = 1 / 光圈相对孔径

所以,选用相对孔径大的镜头,可以降低对景物照明条件的要求。

最后,对于摄像头来说,主要还涉及到相关的镜头接口。常规的接口镜头主要包括 C接口镜头(C-Mount)与CS(CS-Mount)接口镜头。两者最明显的区别就是镜头与摄像机接触至摄像机感光元器件(CCD/COMS传感器)的位置(焦平面)的距离不同。这个距离专业的术语叫做法兰焦距。C接口的法兰焦距为17.5mm,CS接口的法兰焦距为12.5mm。在镜头的使用过程中,通常是C型标准摄像机接C接口镜头,CS镜头接CS型摄像机。但是在使用的过程中C接口镜头可以加装一个5mm厚的延长环与CS型摄像机搭配使用,C接口镜头不加延长圈则会导致镜头碰到传感器靶面,造成传感器损坏。CS型镜头与C型摄像机无法配合,CS镜头与C型摄像机不能组合使用的原因是镜头成像面与CCD受光面距离太远,不能得到聚焦的图像。

2)红外滤光片(IR Filter)

红外滤光片的主要作用是透过人眼可见光波段(380~700nm),滤除掉入镜头中的红外光,这是因为人眼看不到红外光,但是sensor却能感受到红外光,所以需要将光线中的红外光滤掉,防止Sensor产生偏色、波纹,以提高色彩还原度,使图像更接近人眼看到的效果。但对于夜视系统,Sensor需要接收物体发出或反射的红外光线进行成像,此时镜头模组中就不需要红外滤光片了。

3)图像传感器(Sensor)

Sensor是摄像头的核心,负责将通过Lens的光信号转换为电信号,再经过内部AD转换为数字信号。每个pixel像素点只能感受R、G、B中的一种,因此每个像素点中存放的数据是单色光,所以我们智驾系统常用的200万像素或者800万像素,表示的就是有200万或800万个感光点,每个感光点只能感应一种光,这些最原始的感光数据也就是我们常常叫做的RAW Data。

图像传感器的像素单元都分为四部分:微透镜、滤色片、感光片(光电二极管)、电荷存储区。光线照射到Sensor感光组件(光电二极管)上,光强就转换为电荷,并缓存于电荷存储区。

目前的Sensor有两种基本的类型:

CCD传感器:

电荷耦合器件传感器:使用一种高感光度的半导体材料制成,能把光线转变成电荷,通过模数转换器芯片转换成电信号。CCD由许多独立的感光单位组成,通常以百万像素为单位。当CCD表面受到光照时,每个感光单位都会将电荷反映在组件上,所有的感光单位产生的信号加在一起,就构成了一幅完整的图像。

互补性氧化金属半导体:主要是利用硅和锗做成的半导体,使其在CMOS上共存着带N(-)和P(+)级的半导体,这两个互补效应所产生的电流可以被处理芯片记录并解读成影像。

由于结构原因,CCD Sensor只有一个ADC;而CMOS sensor有一行的ADC。这样在数据输出上,CMOS可以做到很高的帧率,而CCD却很难做到高像素和高帧率。

由此,在面向智驾系统更高帧率和高分辨率的前提下,对CMOS应用场景将越来越大。我们在对传感器Sensor选型过程中通常需要考虑如下几个重要参数:

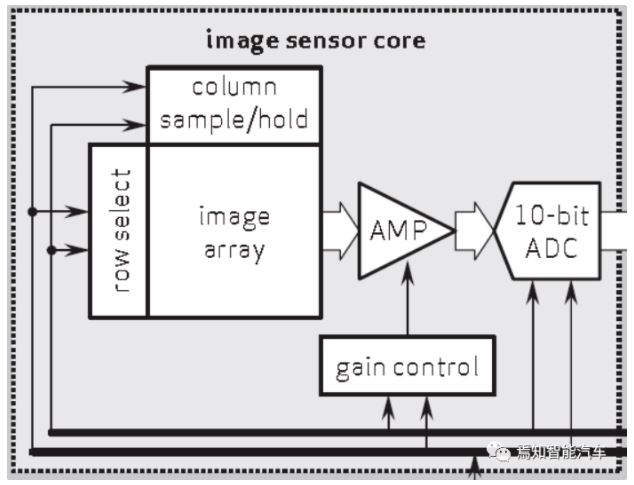

4)传感器核心

典型的图像传感器核心主要由image array(图像阵列)、AMP放大器)以及ADC组成。其中图像阵列Image array是模拟电路,很难做到很先进的工艺,比如40nm这种水平,而且并不是工艺越先进越好(要保证像素感光面的大小)。但是sensor的数字部分(比如内部的图像处理和接口逻辑)是纯数字逻辑,这部分却可以做到很先进的工艺比如16nm。 如下图a)表示了一个典型的sensor的版图如下:

像素阵列可以分为OpTIcal Black(光学黑体)区域、AcTIve Pixel(有效像素)区域以及Dummy boarder(虚拟边界)区域。 一般一个sensor的图像阵列点数会大于实际成像的图像。比如一个1920x1080的sensor,可能实际的Image array的点数是1948x1108。这是由于图线阵列角落的进光量很少,一般会去掉一部分角落的像素点,保证成像质量,从而增加一些功能性的区域,比如Optical Black区域用来作为暗电流的对照(用于黑电平校正),留下虚拟边界作为后续数字处理的时间余量和传递一些额外信息。

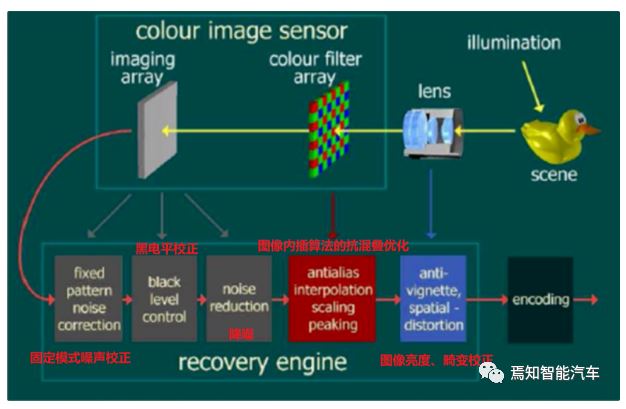

5)ISP图像处理过程

ISP(Image Signal Processor),作为摄像头中一种典型的前端处理单元,主要是对图像传感器输出的信号做前期处理。ISP的功能比较杂,基本上跟图像效果有关的它都有份。它内部包含多个图像算法处理模块,其中比较有代表性的是:扣暗电流(去掉电流噪声),线性化(解决数据非线性问题),shading(解决镜头带来的亮度衰减与颜色变化),去坏点(去掉sensor中坏点数据),去噪(去除噪声),demosaic(raw数据转为RGB数据),3A(自动白平衡,自动对焦,自动曝光),gamma(亮度映射曲线,优化局部与整体对比度),旋转(角度变化),锐化(调整锐度),缩放(放大缩小),色彩空间转换(转换到不同色彩空间进处理),颜色增强(可选,调整颜色),肤色增强(可选,优化肤色表现)等。

依赖于ISP才能在不同的光学条件下都能较好的还原现场细节,ISP技术在很大程度上决定了摄像机的成像质量。负责接收感光元件(Sensor)的原始信号数据,可以理解为整个相机拍照、录像的第一步处理流程,对图像质量起着非常重要的作用。

摄像头模组影像测评 了解了摄像头在各方面的性能指标后,就需要采用一定的评价指标对摄像头整个模组的选型进行有效的评价,以方便对摄像头的运算能力进行全方位评估。 从如上分析影响摄像头成像能力的主要因素来说,关于摄像头模组的显像测评主要包括如下几个重要的指标。

(1)解像力 解像力这个指标主要是通过对相机镜头的还原能力进行测试,测试的方法是用相机拍摄逐渐变细的条纹,然后在电脑中使用10倍~50倍甚至更高倍数的放大倍率来观察所拍摄的画面。解像力值是用底片上视觉可区别的1mm上的极限线条数表示的。 例如,在一个区域中画100条黑线,有的镜头拍出来的影像只能辨认出10条线,有的镜头拍出来的影像则能辨认出100条线,这样就可以认为后者的解像力比前者高。可以看出解像力主要是针对镜头而言的。

(2)杂光、鬼影 由强光造成的照片发白、形成光晕的现象称作“眩光(Flare)”。当太阳光或点光源进入镜头时,镜片表面会反射5%左右的入射光线。各枚镜片表面反射的光线会在镜头和相机内部多次反射,在光源的相对位置形成之清晰亮点,有如幽灵一般,称之为鬼影(鬼影算是光斑的一种)。 这里需要说明的是,很多如果采用纯摄像头方案实现的AEBFCTB这类安全性功能可能会由于检测到类似鬼影而进行误制动。

(3)畸变 相机内参由传感器和镜头在模组内的安装位置决定,其标定的主要目的是建立成像几何模型并矫正透镜畸变。透镜畸变主要分为径向畸变和切向畸变,径向畸变由透镜形状的制造工艺导致,切向畸变由透镜和CMOS或者CCD的安装位置误差导致。 在进行畸变性能评价时,通常是采用对摄像头内参矩阵做整体维度的评价。通常在对摄像头安装到车上时,需要提前对摄像头的内参矩阵进行矫正。相机内参标定通过拍摄空间中不同位置处的标定板,标定光心位置和畸变系数。

(4)视场角 在光学仪器中,以光学仪器的镜头为顶点,以被测目标的物像可通过镜头的最大范围的两条边缘构成的夹角,称为视场角。视场角的大小决定了光学仪器的视野范围,视场角越大,视野就越大,光学倍率就越小。这也是我们在做摄像头镜头模组选择时最常用于评价的性能指标。

(5)亮度均匀性 光亮度均匀性,是指最亮与最暗部分的差异值,就是所拍摄的画面四个角落的亮度与中心点亮度的比值,一般将中间定义为100%。理想的均匀度是100%,均匀度越高,画面的亮度一致性越好。

(6)色彩均匀性 色彩均匀性的测量方法:即至少选择两种颜色RGB级数进行比较。如:R/B和R/G。以确认模组周边与中心色彩一致性是否符合要求。分别测出R/B、R/G、G/B的max以及min值,并用min/max(各组)从而得到需求值,取其中的最小值,从而可以很好的评价传感器的色差能力。

(7) 色彩饱和度 饱和度(Saturation)指的是色彩纯度。是色彩的构成要素之一。纯度越高,表现越鲜明,纯度较低,表现则较黯淡。

(8)信噪比 信噪比是信号均值与背景标准偏差的比值,衡量一幅图片质量好坏的重要指标。信噪比越大,图像画面就干净,看不到“颗粒”、“雪花”。若信噪比小,则可能满是“雪花”,严重影响图像质量。

(9)白平衡 白平衡就是拍照时相机会分析我们拍摄场景的光线环境,并且尽力还原白色,光的色调是通过色温来实现的,色温会告诉相机这些光是暖色调还是冷色调。色温说的是光线的温度,比如暖光或者冷光,色温从低到高,颜色也由偏黄的暖光(色温低)到偏蓝的冷光(色温高)。白平衡的目的是要求在不同光源下(晴天、阴天、白炽灯等)拍摄的图像能获得与人眼观察相符的彩色,并确认是否出现偏色及其他颜色掺杂。

(11) 灰阶 灰阶就是指将最亮和最暗之间的亮度变化区分为不同的层级,每一级就表示一个亮度变化,这里的中间层级越多,那么呈现出来的画面效果也就会越细腻。灰阶层级越多,明暗对比和黑白颜色过渡方面的表现优异图像越清晰,过渡越自然越好。

(12)动态范围 动态范围是用来描述画面中从最暗的阴影部分到最亮的高光部分的光量强度分布范围。动态范围越大,说明图像中能被捕捉下来的层次越丰富。 只要场景中从最亮到最暗的部分所跨越的动态范围在相机感光元件的动态范围之内,那么就能够同时把最亮和最暗部分的细节记录下来。举例来说,如果一台相机的动态范围是8挡,而场景中最亮和最暗部分的曝光相差6挡,那么你就能够记录下场景中所有的细节。不过,如果场景或者拍摄对象的动态范围超过了相机感光元件的动态范围,那么你的照片必然会出现阴影是完全的黑色,或者高光“溢出”变成完全的白色——有时两种情况会同时出现。

(13)其他评价指标 此外,从综合场景的评价角度上讲,其相应的评价标准还可以是测试人员可以通过目测拍摄场景的锐利清晰度、轮廓分明度、动态范围效果以及色彩失真度来判定整体场景的优劣。如果应用到车上,还需要考虑是否存在类似镜头加热等附加功能。因为摄像机加热的主要目的是保证摄像机能正常启动以及正常工作。因为一般电子元器件的工作温度范围是-5℃到45℃左右,所以基于北方冬天能达到零下二三十度的低温,一些元器件就会停止工作,所以应用于北方的摄像机需要FPC电热膜/FPC加热膜进行加热处理,以保证摄像机能正常工作,从而确保整个加热单元会影响到整体的功能输出。

更多信息可以来这里获取==>>电子技术应用-AET<<