卡AI脖子的是算力,没有英伟达和台积电,中国做不出ChatGPT?

2023-02-06

来源:电子技术应用ChinaAET

最近爆火的ChatGPT和AI作画惊艳了无数人,能对话问答、能翻译、能写诗,还能修代码,ChatGPT展示了既强大又通用的语言能力。其强大的通用语言能力背后,是1750亿个模型参数和45TB的训练数据(以它的上一代GPT-3为例)。如此巨大的计算量,没有算力的持续增长,是不可能实现的。ChatGPT及GPT-3这样的大语言模型展示了,当模型的大小和训练量的大小出现量变以后,最后的表现结果就是产生质变。这本质上揭示了“智能”和算力的深刻联系。

算力发展与科技奇点

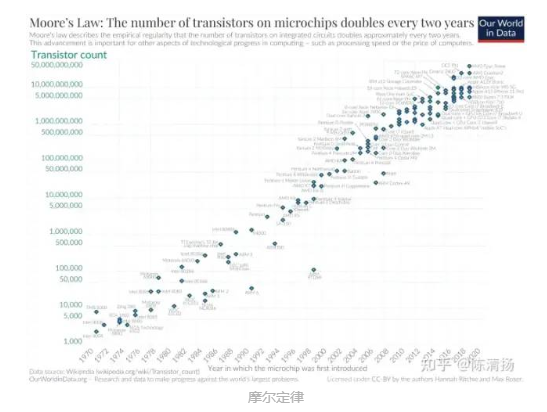

计算机的计算能力便每隔几年翻一倍,计算机的应用也遍地开花:1980年代末出现了互联网,1990年代出现了搜索引擎,2000年代出现了社交网络,2010年代出现移动互联网,而2012年AlexNet横空出世。计算机应用的变迁和发展背后的动力则是算力的发展,当算力达到一定的程度了,相应的应用就会自然涌现。英特尔的创始人Gordon Moore1965年提出了著名的摩尔定律,后来摩尔定律有很多个说法,最简单的说法是,在价格不变的情况下,芯片中的晶体管数量每18个月翻一倍。摩尔定律并不是物理规律,而是一种对于人类科技进步趋势的洞察,即算力的增长是指数的。

美国著名未来学家、奇点临近一书的作者Ray Kurzweil认为,算力的发展其实一直指数增长的过程,这个过程开始得远远早于摩尔定律,譬如世界上第一台电子计算机使用的材料是电子管,而电子管后来被晶体管取代。在电子管之前甚至还有通过机械原理制造的计算机Z3。如今基于硅的集成电路工艺已经小到了一定程度,在未来会遇到散热上的瓶颈,但是这并不妨碍未来人们会有更好的方式和材料来构造计算机,继续保持算力的持续增长。

算力持续指数增长下去的结果就是科技发展的加快,想想从2012年Alex横空出世到现在AI才发展了10年,就已经取得了巨大的进步。而人类14000年前才进入农业时代,200多年前才进入工业革命时代,不到100年前才有计算机,不到20年前才有智能手机,而10年前才有了深度学习的爆发,这的确印证了科技的指数发展。

神经网络的低谷与爆发

1.神经网络的发展,经历了两次低谷期:

第一次低谷是算法:神经网络50年代提出,此时主要由生物学背景的科学家主导。但随着人工智能之父提出的异或问题,人们开始质疑,认为神经网络是骗人的。

但从80年代开始,物理学家开始进入这一阵地。并在1986年,提出了BP算法,通过梯度下降的方式,可以将误差收敛到一个极小值,论上证明了神经网络这种联结主义可用,BP算法大获成功。

第二次低谷是算力:随着神经网络的发展,人们很快就遇到了新的问题,那就是收敛速度和泛化的问题。

简单说就是“慢”。当时的计算器CPU性能还不够强大,对于稍微大点,层数和节点多一点的网络,训练时间太长,稍微大的规模就无法处理了。

2.进入21世纪出现了转机:

数据:21世纪,互联网快速发展,人类通过互联网的运转,获取了过去十多年难以想象的海量数据。这些数据,为神经网络的数据构建和训练带来了可行性。

高级算法:2006年,Hinton在Science首次提出“深度信念网络”的概念。与传统的训练方式不同,“深度信念网络”有一个“预训练”过程,可以方便地让神经网络中的权值找到一个接近最优解的值,之后再使用“微调”(fine-tuning)技术来对整个网络进行优化训练。

预训练+微调,这种两部训练技术的运用,大幅度的减少了多层神经网络的训练时间。在上一篇文章的ChatGPT发展过程中我也有提到,ChatGPT的基本能力来源于预训练,而能力进化和解锁来源于指令微调。

这个阶段,训练和计算基本依靠CPU进行,CPU频率也在逐渐提高,但此时10亿量级的链接,比如2012年的Google X 项目,训练这一模型,耗费了1000台计算机,16000个CPU计算,其训练速度、运行时间、训练成本都不能令人满意。

而因为CPU算力有限,此时深度学习发展速度并不快。

3.GPU的强大计算能力的引入:

CPU是专门为按序列串行处理优化的核心组成;而 GPU 则拥有大规模并行架构,当中包含数千个更小、更高效的核心,专为同时处理多重任务而设计。与仅包含 CPU 的配置相比,GPU 的数据处理速度快得多。

在神经网络在最初的训练过程中,主要依靠的是CPU。

在2011~2012年前后,英伟达显卡GTX580被导入到CNN模型计算,对于大模型的训练,GPU的加速效果达到了CPU的60倍左右。比如上文的10亿个连接的Google X项目,在同等工作量和时间下,只需要64个GPU的16台电脑就可以运算出结果。

2012年,吴恩达用3台GTX680,就完成了谷歌用1000台CPU服务器才能完成的猫脸识别任务,GPU正式被各大互联网头部厂商导入,但依然处于CPU+GPU并行的阶段。

2016年,英伟达推出新的GPU架构,专门针对AI计算进行优化。而在之后的两年时间,基于深度学习的AlphaGo先后战胜李世石和柯洁。

也就是那时候开始,深度学习/人工智能在短时间之内火遍业界、学术界和就业市场。相信几年前的火热场景大家还有影响,一个应届生,只要会一点tensorflow,pytorch,会调参数的调参侠就可以被公司以四五十万招揽。

而因为GPU强大的加速效果,随着以深度学习为核心的各种应用,不断涌现并且快速落地。GPU在此时,成为了AI计算的标配。

从数据,算法、算力,一点点积累,最终造就的就是一次小规模的科技大爆发,而这次科技大爆发的成果就是深度学习,而其所带来的,则是算力需求的大爆炸。

算力需求大爆炸

1.需求大爆炸:

在深度学习新算法+GPU的两大加持之下,AI计算在应用领域极速扩大。

尤其是随着云计算、金融、短视频推荐算法,图像识别(安防、智慧城市)以及自动驾驶的飞速发展,互联网巨头、ZF,公共事业部门、安全部门等,对于算力的需求飞速增长。再加上加密货币的火热,出现了第一次算力需求的大爆炸。

在社会层面,互联网巨头们对于算力的海量需求,大量的数据中心和算力中心被建立,GPU芯片被快速部署到各种服务器,数据中心,并且在持续的进行。

而政府规划层面,东数西算、智算中心也自此诞生。

而英伟达则随着GPU的大量出货,GPU+CUDA独霸市场,股价也开启了从30,涨到800的逆天之旅。

2.GPU局限性

但是,通用GPU在使用过程中,也逐渐显现出局限性,并不能满足每一种需求,因为有的侧重训练,而有的则是侧重推理,有的侧重能效,比如加密货币领域,为了最求更高的能效比,矿卡开始大量取代英伟达的GPU。

其实,这个局限性,在谷歌的AlphaGO就已经显现,最初的AlphaGo完整版本运行在48颗CPU和8块GPU上,这个板本的AlphaGO的反应相对较慢,并不足以颠覆人机大战,李世石一度很有信心。

但实际上,后续与李世石的对弈,谷歌引入了高度定制化的,基于tensor Flow深度学习架构的TPU,按照谷歌的描述,其TPU 平均比当前的 GPU 或 CPU 快15~30倍,能效比更是GPU的70倍,CPU的两百倍。在这一配置下,AlphaGO以绝对优势击败了李世石。虽然TPU通用性差,但效率巨高,后来在谷歌翻译、图像搜索、谷歌照片(Google Photo)、谷歌云视觉API 中大量应用。

与之类似的是,特斯拉的自动驾驶,FSD芯片从18年开始导入,不仅仅依赖于GPU, 而是专门加入了神经处理单元和各种加速器。后续更是开发了Dojo+D1芯片,专门承担算法训练重任。

还有百度,在使用GPU的时候,也采用FPGA研发AI加速。并最终自研了云端全功能AI芯片-昆仑。

而阿里,因为应用场景不同,则是自研了含光800,更加侧重于推理。在城市大脑的业务测试中,1颗含光800的算力相当于10颗GPU。

可以说,在第一次算力需求大爆发下,GPU 虽然独霸市场,但各种偏训练、推理的专用芯片也开始快速的发展。

新的算力需求大爆炸即将到来

深度学习伴随的第一次算力需求大爆炸,To C应用火热的基本没有,更多的是在To B 和 To G,主要在云端部署。GPU+专用芯片,第一次算力需求的大爆发,似乎处于一个相对平衡阶段。

但是,当ChatGPT月活用户接近1亿的时候,事情就不一样了。这是互联网发展20年来,增长最快的消费类应用。这也是人工智能诞生以来,面向C端用户增长最快的速度。

这是获得大众认可的AI C端产品,而过去,人们只会叫他们“人工智障”。天猫精灵或者各种什么同学,有时候能让你气的脑溢血。人们往往用一用,就过了新鲜劲,所以更多的AI还是在B端,G端,用在现在,已经有1亿人对ChatGPT表示出了高涨的热情。大佬们更是给出了超高的评价:

比尔盖茨说,“ChatGPT让我们窥见了即将发生的事情,这项技术以及其革新速度都令人印象深刻。”美国《财富》杂志评价ChatGPT就是人工智能行业的iPhone。商汤智能产业研究院长田丰认为:“ChatGPT验证了当前AI大模型的巨大商业价值和科研价值。ChatGPT的出圈,可能意味着一个AI大规模商业化时代的到来。

ChatGPT让谷歌,微软、百度等一众大佬刚到恐惧,他虽然不是搜索引擎,但用户通过ChatGPT获得更准确、及时、人性化的答案,这个时候还需要搜索引擎吗?谷歌的Gmail创始人保罗·布赫海特认为,谷歌距离被彻底颠覆可能只需要一两年的时间,像ChatGPT这样的AI聊天机器人将摧毁谷歌,消灭搜索引擎结果页面。

ChatGPT取得的成绩,以及各种高度的评价,足够令人重视。而我们需要重视的,是ChatGPT背后的通用大模型技术:他已经在医药研究、虚拟电厂等各种方向开始创新和发展。但当他以To C的方式出圈,会进一步推动这种模型在产业层的应用。

而这样一个需要进行大规模预训练,具有3000亿数据,将近2000亿参数的超级大模型。当前仅仅是GPT-3.5, 近期将会更新GPT-4,他的参数将比3代再高出几个量级。

这个模型的训练,目前OpenAI至少导入了一万多块的英伟达最高端的GPU进行预训练。而触发第一次算力需求大爆炸时的AlphaGO 仅仅需要8块GPU RTX680,而和柯洁对战的go只用了4块GPU。

这种大模型,对算力的需求至少是指数级的增长。当他从实验室走向落地,旦类似的大模型开始根据各行各业做推广和部署,这个算力需求是个无底洞,当前的算力是不够的。甚至于东数西算打造的各种数据中心,也远远难以应对即将到来的,"新的一轮的,算力需求大爆炸"。

我们可能需要更多,不仅仅依赖于数据中心,云计算,更需要算力网络,需要云网融合,甚至需要端测设备也提供算力,将端侧的闲置算力链接并网。我们不仅需要GPU,更需要各种专用的云端训练芯片,推理芯片。我们还需要各种端侧的推理芯片,NPU/AI 芯片,未来的各种终端都需要具有AI算力。不仅仅用于处理端侧的算力需求,还要将闲置的算力贡献到整个算力网络中调配,类似于BTC挖矿。

新的一次的算力需求大爆炸,我相信不会太远,也许在2025年前后就会到来。这是个机会,因为潜力和想象力巨大。但也很难,因为我们在高端算力上缺失严重,我们在高科技领域、半导体领域、高性能计算等方面被各种掣肘。

不过国家正在规划的事情放到一起去看,能看出些东西的。比如GPGPU、算力、训练芯片各种芯片厂家快速获得大额融资;比如各家互联网大厂、新能源汽车主机厂的数据中心,算力中心,智算中心的加快建设;比如国家的东数西算,云网融合,算力网络。

相信赶上不会太远了。

来 源 | 知乎@陈清扬、雪球@捡贝壳的FBB

欢迎关注电子技术应用2023年2月22日==>>商业航天研讨会<<