Meta推出自研AI芯片:押注RISC-V

2023-05-19

来源: 半导体行业观察

正如我们在一年前指出的那样,当一些关键的芯片专家从英特尔和 Broadcom 被聘请到 Meta Platforms 工作时,这家前身为 Facebook 的公司一直是定制芯片最明显的地方。在全球最大的八家互联网公司(也是全球八家最大的 IT 设备买家)中,Meta Platforms 是唯一一家纯粹的超大规模供应商,并且不在云上销售基础设施容量。

因此,Meta Platforms 拥有自上而下的软件堆栈,并且可以随心所欲地创建驱动它的硬件。而且,它有足够的钱这样做,并且在硅片和人员上投入了足够的钱来为它调整软件,毫无疑问,它可以通过控制更多的芯片来节省很多钱。

Meta Platforms 今天在其 AI Infra @ Scale 活动中推出了自主研发的 AI 推理和视频编码芯片,并讨论了其研究超级计算机的部署、适应繁重 AI 工作负载的新数据中心设计,以及其 AI 框架的演变。在本片文章中,我们将专注于元训练和推理加速器,简称 MTIA v1。

从长远来看,CPU、DPU、交换机和路由 ASIC 可能会添加到 Meta Platforms 不会购买的半导体组件列表中。如果 Meta Platforms 真的想造成很大的破坏,它可以将自己的芯片卖给其他人。. . . 奇怪的事情发生了。就像1975 年的宠物摇滚热潮,仅举一个例子。

为什么要自研芯片

在今天上午的一次虚拟活动中,Meta 揭开了其为 AI 工作负载开发内部基础设施的努力的帷幕,包括支持其最近推出的广告设计和创作工具的生成 AI 类型。

这是对 Meta 实力投射的一次尝试,Meta 在采用 AI 友好的硬件系统方面历来进展缓慢,这阻碍了其与谷歌和微软等竞争对手保持同步的能力。

“构建我们自己的 [硬件] 功能使我们能够控制堆栈的每一层,从数据中心设计到训练框架,”Meta 基础设施副总裁 Alexis Bjorlin 告诉 TechCrunch。“需要这种水平的垂直整合才能大规模突破人工智能研究的界限。”

在过去十年左右的时间里,Meta 花费了数十亿美元来招募顶级数据科学家并构建新型人工智能,包括现在为发现引擎、审核过滤器和遍布其应用程序和服务的广告推荐器提供支持的人工智能。但该公司一直在努力将其许多雄心勃勃的 AI 研究创新转化为产品,尤其是在生成 AI 方面。

直到 2022 年,Meta 主要使用 CPU 和专为加速 AI 算法而设计的定制芯片的组合来运行其 AI 工作负载——CPU 在处理这类任务时的效率往往低于 GPU。Meta 取消了计划于 2022 年大规模推出定制芯片的计划,转而订购了价值数十亿美元的 Nvidia GPU,这需要对其多个数据中心进行重大重新设计。

为了扭转局面,Meta 计划开始开发更具雄心的内部芯片,该芯片将于 2025 年推出,能够训练 AI 模型并运行它们。这就是今天演讲的主题。

Meta 将新芯片称为 Meta Training and Inference Accelerator,简称 MTIA,并将其描述为加速 AI 训练和推理工作负载的芯片“家族”的一部分。(“推理”是指运行经过训练的模型。)MTIA 是一种 ASIC,一种将不同电路组合在一块板上的芯片,允许对其进行编程以并行执行一项或多项任务。

“为了在我们的重要工作负载中获得更高水平的效率和性能,我们需要一个与模型、软件堆栈和系统硬件共同设计的定制解决方案,”Bjorlin 继续说道。“这通过各种服务为我们的用户提供了更好的体验。”

定制 AI 芯片越来越成为大型科技公司的游戏名称。谷歌创建了一个处理器,TPU(“张量处理单元”的缩写),用于训练大型生成式人工智能系统,如PaLM-2和Imagen。亚马逊向 AWS 客户提供专有芯片,用于训练 ( Trainium ) 和推理 ( Inferentia )。据报道,微软正在与 AMD 合作开发一种名为 Athena 的内部 AI 芯片。

Meta 表示,它在 2020 年创建了第一代 MTIA——MTIA v1——基于 7 纳米工艺。它可以从其内部 128 MB 内存扩展到高达 128 GB,并且在 Meta 设计的基准测试中——当然,必须持保留态度——Meta 声称 MTIA 处理了“低复杂性” ”和“中等复杂度”的 AI 模型比 GPU 更高效。

Meta 表示,芯片的内存和网络领域仍有工作要做,随着 AI 模型规模的增长,这会出现瓶颈,需要将工作负载分配到多个芯片上。(并非巧合,Meta 最近收购了位于奥斯陆的英国芯片独角兽 Graphcore 的 AI 网络技术团队。)目前,MTIA 的重点完全放在 Meta 应用程序系列“推荐工作负载”的推理上,而不是训练上。

但 Meta 强调,它继续改进的 MTIA 在运行推荐工作负载时“大大”提高了公司在每瓦性能方面的效率——反过来允许 Meta 运行“更加增强”和“尖端”(表面上)人工智能工作负载。

NNP和GPU无法处理具有良好TCO的负载

MTIA AI 推理引擎于 2020 年启动,当时冠状病毒大流行导致一切失控,而 AI 已经超越图像识别和语音到文本翻译,发展到大型语言模型的生成能力,这些模型似乎知道如何做很多他们不打算做的事情。深度学习推荐模型或 DLRM 是一个比 LLM 更棘手的计算和内存问题,因为它们依赖于嵌入——一种数据集上下文的图形表示——必须存储在运行的计算设备的主内存中神经网络。LLM 没有嵌入,但 DLRM 有,内存是主机 CPU 内存容量以及 CPU 和加速器之间快速、高带宽连接对 DLRM 比对 LLM 更重要的原因。

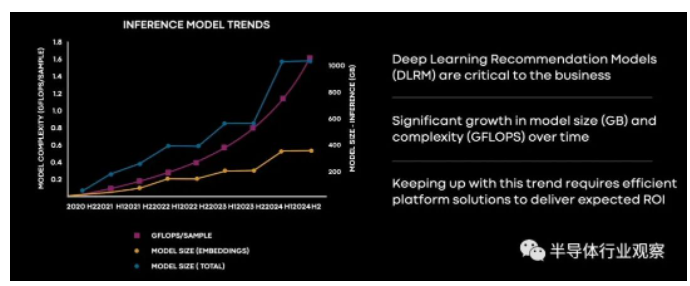

Meta Platforms 的软件工程师 Joel Coburn 在 AI Infra @ Scale 活动中展示了这张图表,展示了该公司的 DLRM 推理模型在过去三年中的规模和计算需求如何增长,以及该公司的预期他们将在接下来的十八个月内成长:

请记住,这是为了推理,而不是训练。这些模型绝对突破了大多数 CPU 中的片上矢量引擎提供的相对少量的低精度计算,以及片上矩阵数学引擎,例如现在英特尔至强 SP v4 和 IBM Power10 芯片上的引擎,即将在 AMD Epycs 上使用可能还不够。

无论如何,这是我们一直看到的那种图表,尽管我们还没有看到它们用于 DLRM。这是一张可怕的图表,但不像这张图那么可怕:

在图表的左侧,在我们早在 2019 年谈到的“Yosemite”微服务器平台中, Meta Platforms 正在用用于推理的神经网络处理器或 NNPI 取代基于 CPU 的推理。基于 CPU 的推理仍在继续,你看,但是随着 DLRM 模型变得越来越胖,它们超出了 NNPI 的范围,然后 Meta Platforms 不得不引入 GPU 来进行推理。我们假设这些不是用于 AI 训练的 GPU,而是 Nvidia 的 T4 和 A40 等 PCI-Express 卡,但 Coburn 没有具体说明。然后随着需要更多的推理能力,它开始变得越来越昂贵。

“你可以看到推理需求很快超过了 NPI 功能,Meta 转向了 GPU,因为它们提供了更强大的计算能力来满足不断增长的需求,”Coburn 在 MTIA 发布演示中解释道。“但事实证明,虽然 GPU 提供了大量的内存带宽和计算吞吐量,但它们在设计时并没有考虑到推理,尽管软件进行了大量优化,但它们的效率对于真实模型来说仍然很低。这使得它们的部署和实践具有挑战性且成本高昂。”

我们强烈怀疑 Nvidia 会争辩说 Meta Platforms 为 DLRM 使用了错误的设备,或者它可能已经解释了“Grace”CPU 和“Hopper”GPU 混合体将如何挽救局面。这一切似乎都不重要,因为 Meta Platforms 希望控制自己在硅片中的命运,就像它在 2011 年启动开放计算项目以开源服务器和数据中心设计时所做的那样。

这就引出了一个问题:Facebook 会开源 MTIA 设备的 RTL 和设计规范吗?

为 MTIA 寄希望于 RISC-V

Facebook 在历史上一直是开源软件和硬件的坚定支持者,如果 Meta Platforms 没有为 MTIA 加速器采用 RISC-V 架构,那将是一个很大的惊喜。当然,它是基于一个双核 RISC-V 处理元件,包裹着一大堆东西,但没有多到无法装入 25 瓦芯片和 35 瓦双 M.2 外围卡.

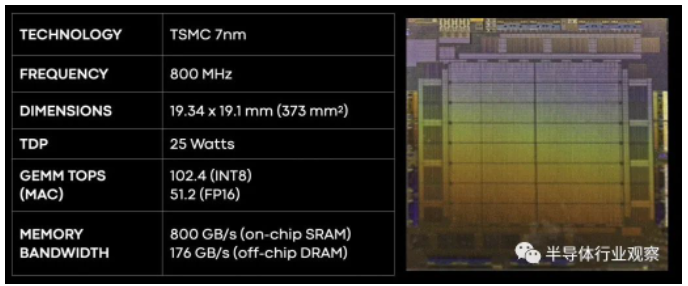

以下是 MTIA v1 芯片的基本规格:

因为它是低频率的,MTIA v1 芯片消耗的功率也相当低,并且采用 7 纳米工艺实现意味着该芯片足够小,可以运行得非常酷,而无需采用台积电最先进的工艺,(如从 5 纳米到 3 纳米不等,中间有 4 纳米垫脚石。)这些都是更昂贵的制程,也许可以留到以后再使用——当这些制程更成熟并因此更便宜时,可以单独或一起使用新一代设备进行训练和推理,就像谷歌对其 TPU 所做的那样。

图片

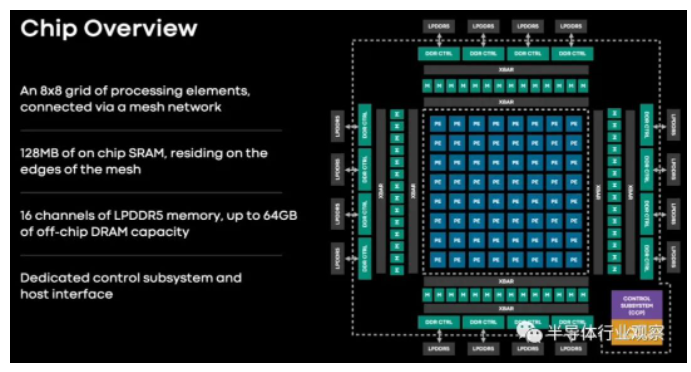

MTIA v1 推理芯片有一个由 64 个处理元件组成的网格,这些处理元件周围环绕着 128 MB 的 SRAM 内存,可用作主存储器或前端有 16 个低功耗 DDR5 (LPDDR5) 内存控制器的高速缓存。这种 LPDDR5 内存用于笔记本电脑,也用于 Nvidia 即将推出的 Grace Arm 服务器 CPU。这 16 个 LPDDR5 内存通道可以提供高达 64 GB 的外部内存,适合容纳 DLRM 所需的那些big fat embeddings。

这 64 个处理元素基于一对 RISC-V 内核,一个是普通的,另一个是带有矢量数学扩展的。每个处理元件都有 128 KB 的本地内存和固定功能单元,用于执行 FP16 和 INT8 数学运算、处理非线性函数和移动数据。

这是 MTIA v1 板的外观:

无法将风扇放在芯片顶部,并在 Yosemite V3 服务器中安装一打这样的风扇。也许这只是为了显示规模?

这是 MTIA 服务器设计中的巧妙之处。Yosemite 服务器中有一个 PCI-Express 交换机的叶/脊( leaf/spine)网络,它不仅可以让 MTIA 连接到主机,还可以相互连接,并连接到 96 GB 的主机 DRAM,必要时可以存储更大的嵌入。(就像 Nvidia 打算对 Grace-Hopper 做的那样。)整个 shebang 的重量为每个系统 780 瓦 - 或者比单个 Hopper SXM5 GPU 在运行full tilt boogie时的 700 瓦多一点。

Nvidia H100 可以在 700 瓦的设备功率下以 INT8 精度处理 2,000 teraops ,而 Meta Platforms Yosemite 推理平台可以在 780 瓦的系统下处理 1,230 teraops。DGX H100 的功率为 10,200 瓦,配备八个 GPU,即 16,000 兆运算,即每瓦 1.57 兆运算。MTIA 的功耗为每瓦 1.58 teraops,并针对 Meta Platform 的 DLRM 和 PyTorch 框架进行了调优——并且将进行更高程度的调优。我们强烈怀疑 MTIA 机箱的单位工作成本比 DGX H100 系统要低得多——否则 Meta Platforms 不会提出来。

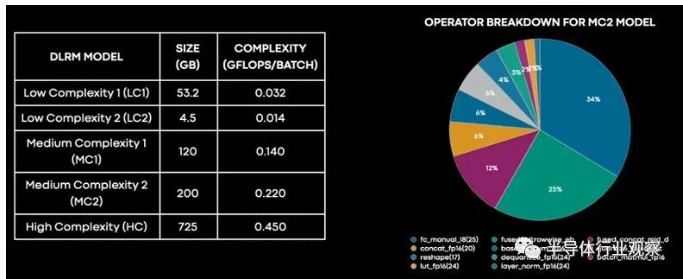

当然,原始进给和速度并不是比较系统的最佳方式。DLRM 具有不同程度的复杂性和模型大小,并不是所有的东西都擅长。以下是 DLRM 在元平台内部的分解方式:

“我们可以看到,大部分时间实际上花在了完全连接的层上,其次是嵌入式底层,然后是连接、转置、量化和反量化等长尾操作,”Meta Platforms 工程总监Roman Levenstein 解释说,。“细分还让我们深入了解 MTIA 在哪里以及如何更有效。与 GPU 相比,MTIA 在全连接层上的每瓦性能最高可达两倍。”

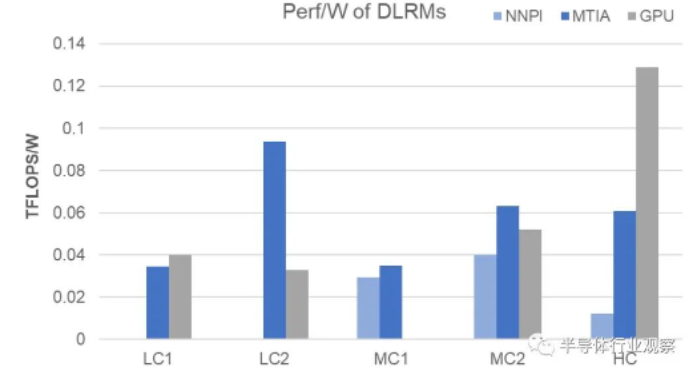

以下是低复杂度、中等复杂度和高复杂度模型的每瓦性能如何叠加:

One More Thing:视频转码器

该公司在今天的活动中透露,除了 MTIA 之外,Meta 还在开发另一种芯片来处理特定类型的计算工作负载。Meta 称为 Meta 可扩展视频处理器,或 MSVP,Meta 表示这是其第一个内部开发的 ASIC 解决方案,专为满足视频点播和直播流媒体的处理需求而设计。

读者可能还记得, Meta 多年前就开始构思定制服务器端视频芯片,并宣布在 2019 年推出用于视频转码和推理工作的 ASIC。这是其中一些努力的成果,也是对竞争优势的新推动。特别是现场视频领域。

“仅在 Facebook 上,人们就将 50% 的时间花在观看视频上,”Meta 技术主管 Harikrishna Reddy 和 Yunqing Chen 在今天上午发表的一篇合着的博客文章中写道。“为了服务于世界各地的各种设备(移动设备、笔记本电脑、电视等),上传到 Facebook 或 Instagram 的视频被转码为多个比特流,具有不同的编码格式、分辨率和质量……MSVP是可编程和可扩展的,并且可以配置为有效地支持 VOD 所需的高质量转码以及实时流媒体所需的低延迟和更快的处理时间。”

Meta 表示,它的计划是最终将大部分“稳定和成熟”的视频处理工作负载卸载到 MSVP,并仅对需要特定定制和“显著”更高质量的工作负载使用软件视频编码。Meta 说,使用智能降噪和图像增强等预处理方法以及伪影去除和超分辨率等后处理方法,我们将继续使用 MSVP 提高视频质量。

“在未来,MSVP 将使我们能够支持更多 Meta 最重要的用例和需求,包括短视频——实现生成 AI、AR/VR 和其他元宇宙内容的高效交付,”Reddy 和 Chen 说。

更多精彩内容欢迎点击==>>电子技术应用-AET<<