MIT实现仅单摄像头精准控制运动机器人技术

2025-07-14

来源:IT之家

7 月 13 日消息,麻省理工学院(MIT)团队提出一种基于视觉的深度学习方法,仅需单个摄像头即可让软体机器人和仿生机器人学习运动与控制。

该技术突破有望大幅降低机器人开发成本,相关成果已于 6 月 25 日发表于《自然》主刊(IT之家附 DOI: 10.1038/s41586-025-09170-0)。

传统工业机器人虽易于建模控制,但刚性结构难以适应狭小或不平坦地形。软体及仿生机器人虽具备环境适应优势,却通常依赖大量传感器和定制化空间模型。

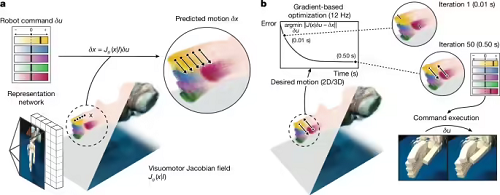

现在,MIT 团队通过深度学习技术解决了这一矛盾。新系统仅需通过单个摄像头捕捉机器人运动画面,结合名为“神经雅可比场(NJF)”的技术,使机器人通过视觉反馈建立对自身形态与运动能力的认知。

研究团队对多种机器人进行了 2-3 小时多视角随机运动视频训练,成功让神经网络通过单帧图像重建机器人三维形态与运动范围。

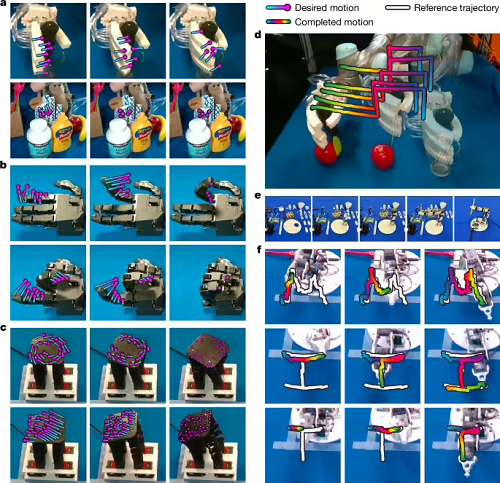

在气动软体机械手、奥利格罗机械手(16 自由度)、3D 打印机械臂及低成本 Poppy 机械臂等测试中,系统实现:

关节运动误差小于 3 度

指尖控制误差小于 4 毫米

可自适应环境动态变化

MIT 助理教授文森特・西茨曼(Vincent Sitzmann)表示:“视觉作为弹性传感器,为农场、工地等非结构化环境中的机器人应用开启新可能。”

CSAIL 主任丹妮拉・罗斯(Daniela Rus)补充道:“视觉反馈使系统建立自身运动动力学内部模型,在传统定位方法失效处实现自监督操作。”

本站内容除特别声明的原创文章之外,转载内容只为传递更多信息,并不代表本网站赞同其观点。转载的所有的文章、图片、音/视频文件等资料的版权归版权所有权人所有。本站采用的非本站原创文章及图片等内容无法一一联系确认版权者。如涉及作品内容、版权和其它问题,请及时通过电子邮件或电话通知我们,以便迅速采取适当措施,避免给双方造成不必要的经济损失。联系电话:010-82306118;邮箱:aet@chinaaet.com。