摘 要: FT算法是在空间频域内的显著目标检测算法。该算法简单、高效,但是在自然图像显著目标检测中,存在显著区域中心像素抑制、显著目标不突出等问题,故对FT算法进行改进。首先,在特征提取阶段,除了提取颜色和亮度信息外,改进的FT算法还提取图像的边缘信息,利用Canny算子检测图像的边缘并用梯度算子表示边缘特征,使得显著区域的边界信息更加丰富;然后,利用中心优先规则线性处理显著图,提高显著区域的中心像素的亮度,突出显著区域,去除冗余信息。仿真结果表明改进的FT算法是切实可行的。

关键词: 显著目标检测;Canny算子;梯度;中心优先

0 引言

视觉注意机制是人类视觉系统的重要机制,它能够从复杂的图像中准确识别显著目标。一般来说,显著区域包含较多的信息,显著目标检测被广泛应用于许多图像处理领域,例如感兴趣区域的自适应压缩、图像和视频的质量评估[1]、视频监控[2]、图像分割和草图检索等。

显著性目标检测源于视觉注意模型,是一种模拟人类视觉智能的重要模型,它得到图像中最显著的区域。大量的研究表明视觉注意模型分为两种类型:自底向上的数据驱动的显著性提取和自顶向下的目标驱动的显著性提取。由于视觉内容需要大量的先验知识,自顶向下的方法应用不多。而自底向上的方法受图像特征支配,不依赖任何先验知识,被广泛研究和应用。比较经典的自底向上的视觉注意模型是Itti[3]模型,Itti是在特征整合理论的基础上,利用高斯金字塔进行非均匀采样得到9个尺度的图像,计算各尺度的颜色、亮度和方向特征,由中央周边差算子计算各尺度上的显著图,最后把各个尺度的显著图融合得到显著图,但是Itti算法得到的显著图的分辨率低,计算量较大。基于图的显著性算法(Graph-Based Visual Saliency,GBVS[4]),在Itti算法的基础上进行了改进,在特征提取阶段,采用Markov链方法计算显著值,显著目标相对完整。基于空间频域分析的算法有两种,剩余谱方法(Spectral Residual,SR[5])和全分辨率方法(FT[6])。SR算法运算效率高,并且该算法的显著图和人眼感知具有一致性。但是SR算法不能计算颜色的显著度。FT算法是基于空间频域分析的,比SR算法保留了较多的高频信息,显著目标的边界比SR算法清晰,但同时也引入了噪声。

FT算法是基于空间频域分析的显著算法,该算法简单高效,但是显著区域中心像素抑制,显著目标不突出。故本文在提取颜色和亮度特征的基础上,加入提取图像的边缘特征,提高显著区域的轮廓信息的清晰度,得到显著图,最后利用中心优先规则对显著图做线性处理,优化显著图,提高显著区域的亮度。

1 FT算法

FT算法是Achanta等在2009年提出的全频域分析算法,利用颜色和亮度特征来估计中央周边差对比度,叠加多个带通滤波器得到全分辨率显著图。

1.1 FT算法原理

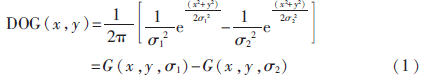

设wlc为低频截止频率,whc为高频截止频率。为了突出大的显著对象,wlc需尽可能的低。为了得到较好的轮廓信息,whc选择较高。本算法选择DOG滤波器作为带通滤波器。DOG公式如下:

式中, 1和

1和 2是高斯分布的标准差。DOG带通滤波器的通频带宽是由

2是高斯分布的标准差。DOG带通滤波器的通频带宽是由 1与

1与 2的比值决定的。多个DOG滤波器叠加可由滤波器的标准差的比值ρ表示:

2的比值决定的。多个DOG滤波器叠加可由滤波器的标准差的比值ρ表示:

在计算显著图时, 1和

1和 2的取值决定带通滤波器保留图像中的频率范围。为了使ρ变大,令

2的取值决定带通滤波器保留图像中的频率范围。为了使ρ变大,令 1为无穷大,这将在截止直流频率的同时保留所有的其他频率。使用一个小的高斯核去除高频率的噪声以及纹理。其中小的高斯核选择二项滤波器代替。使用1/16*[1,4,6,4,1]二项滤波器,并令whc=π/2.75。

1为无穷大,这将在截止直流频率的同时保留所有的其他频率。使用一个小的高斯核去除高频率的噪声以及纹理。其中小的高斯核选择二项滤波器代替。使用1/16*[1,4,6,4,1]二项滤波器,并令whc=π/2.75。

视觉显著值的计算公式为:

Iu(x,y)是图像在lab空间的像素算术平均值,Iwhc(x,y)是图像的高斯模糊模板(使用5×5二项式滤波器),用来消除纹理细节以及噪声,‖‖是欧式距离。

1.2 FT算法的显著图

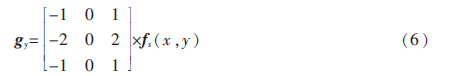

根据公式(3),得出FT算法的仿真结果如图1所示。

其中,第一列是原图像,第二列是FT算法得到的显著图。从FT算法的显著图中看出,前两幅图像显著区域弱化,背景对比度较差,显著区域中心像素抑制,不显著区域被突出。第三幅图像背景简单,显著图相对较好,背景冗余信息处理较好,但仍存在部分显著区域弱化的问题。针对这些问题,利用改进的FT算法进行完善。

2 算法的改进

算法的改进分为两个部分:首先在特征提取阶段,加入了全局边缘特征提取处理,能使显著区域边界更加清晰;然后利用中心优先规则对显著图做线性处理,解决显著区域中心像素抑制和显著区域不突出等问题。

2.1 基于边缘特征提取的全局处理

FT算法在特征提取上采用的是颜色和亮度的特征,由于自然图像内容丰富,边缘信息比较重要,因此本文在FT算法的颜色和亮度特征提取的基础上,加入图像的边缘特征,使得边缘细节更加丰富。

由于Canny算子错误率低、边缘点能较好地定位以及单一的边缘点响应等优点,故采用Canny算子检测图像的边缘信息。图像梯度信息可以有效地表现图像边缘的强度和方向,故采用Sobel模板作为导数算子,计算图像灰度沿着水平和垂直两个方向的偏导数,进而计算出梯度的大小和方向。步骤如下:

(1)用一个高斯滤波器平滑输入图像。高斯函数定义为:

设输入图像为f(x,y),平滑后的图像为fs(x,y),公式为:

fs(x,y)=G(x,y)*f(x,y)(5)

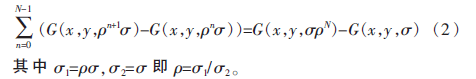

(2)边缘提取。选择Sobel模板计算梯度的大小。gx代表横向检测的图像灰度值,gy为纵向边缘检测的图像灰度值。其具体公式如下:

梯度的幅值为:

|g|=|gx|+|gy|(7)

那么公式(3)的显著值定义更改为:

2.2 基于中心优先规则的局部处理

一般来说,图像像素的中心分布常被用于显著区域定位和估计,这是因为人们拍照时往往把感兴趣的目标定位在图像的中心位置。结果表明每个像素到图像中心的距离能够较好地预测显著目标。根据格式塔法则,视觉形式可能具有一个或几个中心的图形。这表明接近注意焦点的部分被认为显著,远离注意焦点的部分被认为是背景。故本文提出中心优先[7]的概念,这能使显著的边缘更加显著,有效地去除背景中的小补丁,更好地评估显著图的性能。

使用一个二维的高斯函数确定图像的中心,定义图像的高度为H,宽度为W,高斯函数在二维空间定义为:

图像中任意像素点(x,y)的最终显著值为:

S(x,y)=S′FT(x,y)G(x,y)(10)

其中G(x,y)为像素点(x,y)在中心优先图中的像素值。

3 仿真结果分析

本实验是在MATLAB 2012a平台中实现上述算法,采用的图像来自MSRA-1000数据库,本数据库包含1 000幅自然图像和所对应的人工分割图。FT算法和改进的FT算法的显著图如图3所示。

从显著图的对比结果看出,改进的FT算法提取的显著图边界信息丰富,显著区域亮度提高,显著区域中心对比度提高。该算法提取的效果更加符合生物的视觉感知,比FT算法效果好,准确度较高,显著性更明显。

4 结论

本文在视觉注意模型的基础上,对FT算法进行了改进。仿真结果表明该算法在自然图像数据库中能够较好地检测显著目标,此算法的原理是在特征提取阶段,加入了边缘特征提取处理,使得边缘细节更加丰富,然后利用中心优先线性处理显著图,得到最终的显著图,提高了显著区域和显著区域中心像素的亮度,显著目标得到了更好的检测。改进的算法简单、高效,明显优于FT算法。但该算法仍存在一些不足,例如显著目标内部的细节不明显,仍需进一步完善。

参考文献

[1] WANG Z, LI Q. Information content weighting for perceptual image quality assessment[J]. IEEE Trans. Image Process, 2011,20(5):1185-1198.

[2] LOPEZ M T, FERNANDEZ-CABALLERO A, FERNANDEZ M A, et al. Visual surveillance by dynamic visual attention method[J]. Pattern Recognition, 2006, 39 (11):2194-2211.

[3] ITTI L, KOCH C, NIEBUR E. A model of saliency-based visual attention for rapid scene analysis[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1998, 20(11):1254-1259.

[4] HAREL J, KOCH C, PERONA P. Graph-based visual saliency[J]. Neural Information Processing Systems, 2007, 19(1): 545–552.

[5] Hou Xiaodi, Zhang Liqing. Saliency detection: a spectral residual approach[C]. IEEE Conference on Computer Vision and Pattern Recognition, Shanghai, 2007:2280-2287.

[6] RADHAKRISHNA A, SHEILA H, FRANCISCO E, et al. Frequency-tuned salient region detection[C]. Los Alamitos: IEEE Computer Society Press, 2009: 1597-1604.

[7] GOFERMAN S, ZELNIK-MANOR L, TAL A. Context-aware saliency detection[C]. Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, San Francisco: IEEE Computer Society Press, 2012: 2376-2383.