摘要:属性词的聚类是领域实体属性抽取中的一个重要步骤。在未知领域和大量文本中,人工标注寻找十分困难。本文将一种基于深度学习框架的词语嵌入表示方法(Word Embedding)引入到领域实体属性词聚类研究中,在无监督条件下解决大规模语料、领域实体属性词表人工参与构建代价较高的问题,并进行了适当的扩展,取得了较好的效果,可以为信息抽取等后续高级任务提供较好服务。

0引言

随着机器学习理论的发展,基于自然语言处理的传统信息抽取技术面临着各种机遇和挑战。特别是有监督的学习方法需要大量人工去标注语料,代价昂贵,成本较高,在现行的机器学习应用研究当中,逐步被半监督、无监督和混合学习方法取代。

在领域实体属性抽取这一课题中,数据来源广泛,载体形式多样,大量的信息载体在互联网上生成和传播,从结构化的数据库,半结构化的百科网页,到完全非结构化的自由文本,给信息抽取工作带来了各种挑战和机遇。传统的监督学习方法通过对大量已经标注的样本来学习得到映射模型,然后再对未知样本进行标签预测。本文针对前人在使用监督学习过程中语料标注工作量大、代价高的实际,提出了一种基于词语嵌入式表示的无监督词语聚类方法。假设同类别的属性词在文本中具有相同或相近的语用和语境,利用深层神经网络架构学习出词语的嵌入式表示,也称词向量(Word Embedding),使其带上文本空间的各种特征信息,有助于降低大规模语料人工寻找构建属性词表的困难。实践证明此方法聚类出的词语再通过后续的扩展及过滤步骤,基本能够达到专家要求的构建标准。

1相关理论

领域词汇的自动聚类可以看成是自然语言处理领域的一项重要任务,并发展出较多的研究成果。如Sven Martin等提出了基于困惑度为代价函数的贪婪聚类算法对词表中的词进行归类,可使训练语料的困惑度最小,但算法时间代价高[1];陈浪舟等在前人研究的基础上进行了优化,提出基于词的相似性分层聚类算法,并用于基于词类的可变长统计语言模型研究当中,取得了较好的效果,但是需要借助于专家预先设定的分类系统[2];程显毅等利用属性和属性值组合的概念模板,并借助于Google搜索进行频繁挖掘,但实现过程较复杂,增加了人力成本[3];另外还有基于LDA分析进行词语聚类等方法,但其需要人工预先设置主题数目[4]。以上论文所使用的方法基本上可以分为基于规则的方法、基于统计的方法以及规则加统计的混合方法,多数花费代价大,依赖性较高。

深度学习(Deep Learning)是近年来研究的热点,在图像、语音和文本这三大信息载体领域均有突破性进展。基于深度学习的词向量是近年来研究比较多的一种无监督的学习方法[5],在研究海量高维文本、未知领域专业文本、陌生语种文本等问题中体现出极大的优越性,其人工参与程度小、自动化程度高,受到越来越多的学者关注,并且产生了多种扩展模型。其中,word2vec(Word to Vector)是Google在2013年开发的词向量转化工具,可以学习出词语的语义、语法和语用信息,计算词语的相似度,是本文研究的工具之一。

11word2vec理论描述

词向量是训练神经网络语言模型过程中的产物,与传统的向量空间模型VSM(Vector Space Model)相比具有维度低、快速、精确等优点[6]。

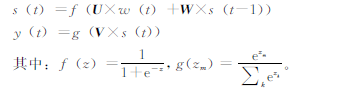

如图1所示,最下方表示的是前n-1个词语:wt-n+1,…,wt-2,wt-1,利用神经网络语言模型可以预测出下一个词wt。

网络的第一层为输入层:将前n-1个词语的向量首尾拼接,组成(n-1)×m维的长向量,其中m是初始规定的词向量维度。

网络的第二层为为隐藏层:与普通神经网络类似,偏置项可以随机初始化,激活函数选用tanh。

网络的第三层为输出层:使用softmax函数将输出值的概率归一化。

12循环神经网络语言模型

循环神经网络语言模型(Recurrent Neural Network Language Model,RNNLM)是Mikolov于2010年提出的一种基于循环神经网络(Recurrent Neural Network,RNN)、用来训练语言模型的改进方法[7],比Bengio的神经网络模型更出色,也是本文所使用word2vec工具的算法原理模型。循环神经网络语言模型如图2所示。

图2中,RNNLM包含一个输入层w(t),代表在t时刻输入词的1ofN编码,以向量形式输入;一个循环连接的隐含层s(t),维持了句子的历史信息和输出层y(t);输出层输出词的概率分布,以及它们对应的权重矩阵U,V,W。

其中,隐含层s(t)和输出层y(t)的值可以通过下面公式得出:

13基于语义相似度的聚类

词语作为一种符号的集合,其在文本中有着特殊存在和表示形式,在中文领域的分词、文法、语境、修饰等各种难点对机器学习来说均是巨大的挑战。其中,基于语义相似度词聚类依旧是研究的重点和难点。

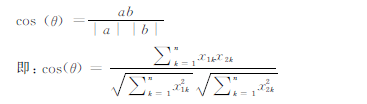

本文结合领域实体属性抽取这一课题,利用维基百科中文语料无监督地训练出词向量,然后再利用向量的夹角余弦距离公式计算词语之间的距离,挖掘出领域实体所需的属性词,为后续的工作做准备。

对于两个n维样本点a(x11,x12,…,x1n)和b(x21,x22,…,x2n),可以使用类似于夹角余弦的概念来衡量它们间的相似程度。

夹角余弦距离公式:

2实验分析与验证

21实验预处理

本文从维基百科中爬取了部分装备语料,如图3所示。由于内容的开放性,用户可以自由添加更改百科的内容,部分内容不规范,经过预处理筛选后共有2 800篇能够用于实验。借助于中科院的ICTCLAS分词系统和CRF++-058工具包,语料经过分词、词性标注、断句、命名实体识别后,以备后用。

22属性词的聚类挖掘和扩展

考虑到人工寻找属性词语会出现遗漏、费时等困难,本文使用Python27中gensim工具包(Google的word2vec工具源码python封装)进行词向量的训练和属性词的挖掘,选用大规模维基中文语料(截止2015年1月,共12 GB)图3未处理语料样例进行学习,确保属性词语的覆盖。研究在设置不同维度、不同窗口条件下对属性词挖掘效果的影响。借助于实验室已有的领域专业词典,设置了两组对比实验,并对实验效果进行初步分析。测试评价选用通用的准确率P、召回率R和查全率F作为评价标准。

![Z0B%QFXB$_}FD)%1F1C]7{2.jpg Z0B%QFXB$_}FD)%1F1C]7{2.jpg](http://files.chinaaet.com/images/2016/03/01/6359246045052700004972412.jpg)

根据先验知识,选取军事装备领域常用的属性词语“速度”、“重量”、“航程”、“排水量”等进行聚类挖掘,部分结果如表1、表2所示。表1与“速度”距离最近的10个词语

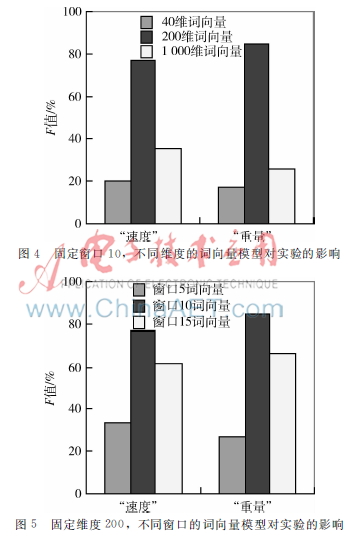

实验过程中,预先训练出40、200、1 000维度词向量模型,窗口大小均有5、10、15三种,共9种组合,为了防止漏词,设置最小词频总数为1。经过反复调整,部分结果如图4、图5所示。

23结果分析

由于领域文本的特殊性,非专业人员容易遗漏特定的属性词,在网络大规模海量语料面前会显得束手无策。

表1和表2中所展示的结果是利用词向量模型计算出的与“速度”、“重量”距离最近的10个词语(窗口为5、维度为40),部分结果不是很准确,个别词语与“速度”、“重量”关系不大,如:“级位”、“反应时间”、“M240B”、“车高”等,经过仔细分析,有些词语虽然不是严格意义上的同义词或者近义词,但也是相关的,如扩展出“推重比”、“恒功”、“扭矩”等陌生领域相关词汇,这与语料的质量有很大关系。

图4和图5表明,在窗口为10、维度为200时,属性词的聚类抽取效果最好。经过分析,可能的原因是:窗口太小,不能足够考虑上下文历史信息(图5中337%和274%),而窗口太大又容易造成信息冗余,产生“噪声”,

影响属性词的抽取(图5中612%和661%);在模型维度选取方面,向量维度过小F值较差(图4中204%和177%),与模型的构建不合理以及训练不够充分有关,当维度为1 000时,又引入了大量的相关词,也使F值下降(图4中359%和256%),同时硬件的计算开销也将增大。经过反复验证,最终设定维度为200、窗口为10,效果最好(图4、5中766%和846%),这与属性词在文本中出现的行文表达结构有关,需要根据不同任务反复调整。

3结论与展望

本文在前人工作的基础上,做出了一些改进和简单尝试,将深度学习中的词向量模型引入到属性词语聚类抽取研究当中,然后再结合专家词典进行评测,取得了不错的效果,对于后续的研究有一定的借鉴意义。但也有较多不足:文本的分词以及语料的规范性都需要进一步提高;在训练神经网络语言模型时,需要大规模语料覆盖,如何获取高质量的大规模语料依旧是需要考虑的问题;本文仅仅是用向量的夹角余弦公式指定泛化词语进行相似度查询聚类,会产生偏差,且结果还需要进一步清洗过滤。下一步研究将从文本的语言学特征入手,结合其他词语距离度量方法,更好地实现信息抽取任务。

参考文献

[1] MARTIN S, NEY H. Algorithms for bigram and trigram word clustering[C].In:Proc European Conference Speech Communication and Technology,Madrid,1995:1253-1256.

[2] 陈浪舟,黄泰翼.一种新颖的词聚类算法和可变长统计语言模型[J].计算机学报,1999,22(9):942-948.

[3] 程显毅,施佺,沈学华,等属性和属性值组合的概念模板[J].北京大学学报(自然科学版),2013,49(1):15-19.

[4] 彭云,万常选,江腾蛟,等一种词聚类LDA的商品特征提取算法[J].小型微型计算机系统,2015,7(7):1458-1463.

[5] 刘树杰,董力,张家骏,等.深度学习在自然语言处理中的应用[J].中国计算机学会通讯,2015,11(3):9-16.

[6] BENGIO Y,DUCHARME R,VINCENT P,et al. A neural probabilistic language model[J].The Joural of Machine Research,2003(3):1137-1155.

[7] MIKOLOV T,KOMBRINK S,BURGET L,et al. Extensions of recurrent neural network language model[C].Acoustics,Speech and Signal Processing(ICASSP),2011 IEEE International Conference on,IEEE,2011:5528-5531.