英伟达也在下一盘AIPC的大棋

2024-01-15

来源:虎嗅APP

2023年,英伟达几乎一整年都在关注高端显卡、AI大模型、超级计算等数据中心业务,以至于市场都快要忘记英伟达在PC市场上也是垄断全球市场的硬件“军火商”。

事实上,在数据中心业务中赚得盆满钵满的同时,英伟达并没有忘本,黄仁勋早已开始盘算,如何用AI到“电竞椅和办公桌”上去赚钱了。

在刚刚结束的2024 CES上英伟达发布了大量聚集PC端的AI应用和GPU新品。包括GeForce RTX 40 SUPER系列显卡,NVIDIA AI Workbench,开源库TensorRT-LLM,以及生成式AI驱动的语音和动画模型在内的NVIDIA ACE微服务。

一系列PC端的GPU产品和应用,全部围绕本届CES上PC厂商们最关注的话题AIPC。然而,对于一心扑在AI上的英伟达来说,对PC用户的“关心”,还保留了多少呢?英伟达对业界热炒的AIPC到底是什么态度?

PC业务的前景不如数据中心

事实上,在2023年AI大模型爆发以前,英伟达最大的市场一直是PC端的“游戏”板块。

英伟达从2015年开始把主营业务分为游戏(Gaming)、企业(Enterprise)、高性能计算和云(HPC & Cloud)、自动驾驶(Automotive)几个板块。也是自2015年起,超算和云,也就是未来的数据中心业务,开始在英伟达的营收中一步步走向高位。

2016年,英伟达对其业务板块进行了调整,去掉了Enterprise和HPC & Cloud两个板块,取而代之的是今天的专业可视化(Professional Visualization)和数据中心(Datacenter)。英伟达还首次单独公布了这几个业务板块的营收情况。游戏业务的目标用户就是个人电脑,专业可视化的用户则多数是商业客户使用的工作站。

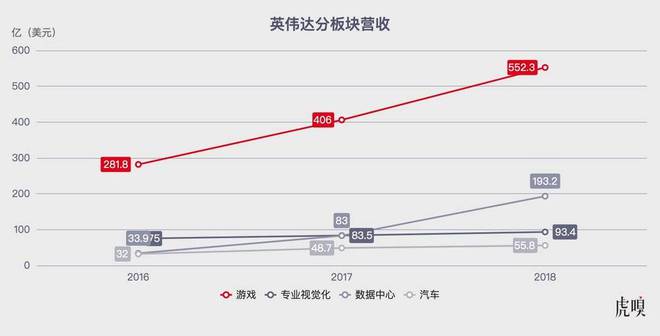

2016年英伟达全年的总收入为50.10亿美元。在2016年1月31日结束的财年中,英伟达的游戏业务收入为28.18亿美元;专业可视化业务的收入为7.50亿美元;数据中心业务的收入为3.39亿美元;自动驾驶业务收入为3.20亿美元。

其中游戏业务和专业可视化分别占总收入的56.25%和14.97%,今天如日中天的数据中心,在当时只占总收入的6.77%。

个人电脑市场虽然稳定,但市场似乎已经能够看到天花板了,不仅增长速度有限,且由于技术门槛不高,这一领域的市场竞争也日益激烈。

2017、2018年,AI技术首次爆发。给英伟达带来了一条新的增长曲线。

2018财年,GPU加速计算对于深度学习的支持使得英伟达的数据中心业务快速增长,当年数据中心业务的收入为193.2亿美元,专业可视化为93.4亿美元。数据中心的营收和增幅都远超专业可视化。

数据中心业务的飞速发展,可以说是把英伟达从传统游戏硬件供应商,带上了多元化技术公司的轨道。

市调机构TBRC在2024年1月发布的最新报告中预测,2023年全球个人电脑市场规模约为2040.9亿美元,预计到2024年将增长到2123.8亿美元,复合年增长率(CAGR)为4.1%。个人电脑市场规模预计在未来几年将保持增长。到2028年,或将增至2677.1亿美元,复合年增长率为6.0%。

数据中心的市场规模和增长潜力则比个人电脑更大。2023年的全球数据中心市场规模约2526.8亿美元,比个人电脑市场规模大了约20%。预计到2024年将增至2749.8亿美元,复合年增长率(CAGR)为8.8%。未来几年数据中心市场规模的增长也更为强劲。TBRC预计,到2028年,这一市场的规模将增至3884.1亿美元,复合年增长率(CAGR)为9.0%。

相比于个人电脑业务,数据中心无论是市场规模、市场竞争格局,还是用户需求、技术发展趋势,不管当下还是未来,都明显更好做,也更赚钱。

数据中心有多赚钱?

在英伟达最新的2024财年第三季度财报中,快速上升的数据中心业务营收1451.4亿美元,占总营收的80%,完全碾压了英伟达在PC端的传统核心业务“游戏”。对于英伟达来说,数据中心业务不管是当下还是未来,都是最能赚钱,赚钱最快,赚钱最简单的业务。

今天的技术趋势强烈指向云计算、大数据、人工智能和机器学习等领域,这些都是数据中心业务的关键驱动力。

AI推动着各家公司对高算力、超级算力的需求持续上涨。2023年年中,科技博客GPU Utils对GPU短缺问题做了一次调查,博主Clay Pascal给出的调查结果称,彼时谷歌云拥有大约2.5万块H100,微软云服务Azure可能有1万-4万块H100,甲骨文的情况应该类似。Azure的大部分容量都将流向OpenAI。

Clay Pascal预测对于H100的需求,OpenAI可能需要5万块,Meta可能需要2.5万块,大型云厂商可能每家都需要3万块,加上其他一些初创企业,可能总共需要大约43.2万块H100。以每块约3.5万美元计算,所需GPU的价值约为150亿美元。这还不包括中国公司。

Clay Pascal在博客中写道:我被告知,对于需要100或1000块(英伟达GPU)H100的公司来说,Azure(微软云服务)和GCP(谷歌云服务)实际上已经没有容量了,亚马逊也接近没有容量了。

研究机构Omdia的调研结果则称,英伟达在2023年第三季度售出了近50万个A100和H100 GPU,基于H100的服务器的交付周期已延长至36到52周。虽然不知道目前英伟达的补货情况,不过从OpenAI近期接连发生的断网,停账号,以及新功能升级来看,不管补货能力如何,需求的巨大缺口仍在。

在巨大的需求面前,英伟达也开始了坐地起价。在芯片行业中,高端产品的利润率通常较高,不少高端产品的利润率可达50%以上。而英伟达的高端GPU利润率高得可怕,投资银行Raymond James的消息称H100 GPU的成本只有3320美元,但英伟达卖出的价格为2.5-3万美元,利润率高达1000%。

如今英伟达a100和H100服务器的价格,在国内更是炒得离谱,2023年最后三个月,8卡H100服务器的价格上浮一度达到300万元人民币。

英伟达有多需要AIPC?

数据中心这么好赚,那是否意味着英伟达会就此减弱对PC市场的关注呢?

短期来看恐怕还不会,毕竟在过去30年里,PC一直是英伟达的主战场。在这里,英伟达不仅有优势,有经验,更重要的是有信心。

个人电脑市场,特别是游戏和专业图形处理领域,在今天仍然是英伟达重要的收入来源。英伟达2024财年第三季度业绩显示,游戏业务营收为285.6亿美元,同比增长超80%。随着游戏行业的发展和虚拟现实技术的进步,PC市场的增长潜力仍然巨大。

另一方面,英伟达在PC市场上,亦处在垄断地位。英伟达在2022年全球独立GPU市场中的市占率为88%,AMD和Intel仅占8%和4%。

更重要的是,英伟达在GPU方面丰富的产品线,可以在PC市场上长期发货优势。英伟达提供了一系列针对不同用户需求的GPU产品,包括面向游戏玩家和创作者的Ampere,以及面向数据中心的Hopper3。英伟达还构建了包括驱动程序、开发工具和应用程序在内的全面生态系统。

从目前来看如果英伟达的RTX40系列显卡在PC上能够支持新的AI业务,那么未来仍将独占这一百亿级别的市场,甚至通过AI技术的升级,进一步扩大个人pc市场中GPU的装机率,推动全球市场规模更上一个台阶。

2023年数据中心业务的增长速度惊人,与AI大模型这一新兴技术的爆发密切相关。然而,AI大模型目前对全球科技市场来说仍处在非常早期的阶段,未来的增长持续性到底如何,对云端服务器的需求如何都未可知。

而PC业务,在过去30年中已经走出了一条稳定的增长曲线。由此可想,虽然英伟达势必会重点投资更有利可图且增长潜力更大的数据中心业务,但一定也不会把早已站稳脚跟的PC业务市场拱手让人。

RTX 40系列的机遇和挑战

AIPC概念在市场上被热炒,很多厂商都在提出把AI落地到本地,从而降低云计算成本、提高安全性和响应效率。这无疑给PC端的GPU创造了新的市场机遇。

英伟达在2024 CES上最新发布的GeForce RTX 40 SUPER系列显卡中,GeForce RTX 4080 SUPER在AI视频生成上比GeForce RTX 3080 Ti快1.5倍,图片生成上快1.7倍。SUPER GPUs的Tensor Cores能够实现每秒高达836万亿次AI运算(TOPS),从而为游戏、创作和日常生产力带来变革性的AI能力。

NVIDIA AI Workbench则允许开发者快速创建、测试和定制预训练的生成式AI模型和大型语言模型(LLM)。TensorRT-LLM是一个开源库,用于加速PC上大型语言模型的运行。最新版本的TensorRT-LLM现已可用,它为PC增加了更多预优化模型,与其他推理后端相比,运行速度提高了多达5倍。

此外,英伟达还发布了生成式AI驱动的语音和动画模型在内的NVIDIA ACE微服务,使开发者能够向游戏中添加智能、动态的数字化角色。此外,NVIDIA还发布了“Chat with RTX”技术演示,它允许AI爱好者通过所谓的“检索增强生成”(RAG)技术,轻松地将PC上的大型语言模型(LLM)连接到自己的数据。

这些新品都针对生成式AI做了大量优化,为GPU在未来的AIPC中发力提供了机会。

有趣的是,最近有研究团队发现RTX4090在一定条件下甚至有可能替代服务器级芯片。

上海交通大学的研究团队就开发了一个名为PowerInfer的高性能CPU/GPU混合LLM推理引擎。这款引擎大幅降低了对GPU内存的需求,并减少了CPU与GPU之间的数据传输,从而提高了整体效率。可以在单个NVIDIA RTX 4090 GPU上运行大型语言模型(LLM),达到平均每秒产生13.20个token的速度,峰值速度更是高达29.08 tokens/s,这与顶尖的A100 GPU服务器性能相差无几,仅低18%,适用于多种LLM应用场景。

PC端GPU在AI加持下虽然机遇巨大。但在AIPC的大潮流中竞争也比高端GPU更激烈。

如今,英伟达要面对的竞争中已经不只有AMD和Intel了。苹果M系列芯片提出的统一内存架构(Unified Memory Architecture, UMA),给生成式AI的预训练过程提供了一种选择。

UMA允许CPU和GPU共享相同的物理内存,减少了数据在不同内存之间的复制需求,提高效率。此外苹果的硬件优化使其设备在执行AI相关任务时能耗更低。苹果的硬件和软件高度集成的特性,也为特定的AI应用提供了更好的优化空间。

目前,已经有大量AI大模型开发者开始尝试使用苹果电脑训练大语言模型。最新款Mac Studio的顶配版本,已经可以训练700亿参数的LLaMA2模型。

不过,虽然UMA具备诸多优势,但它更多地集中在苹果自己的生态系统内,与外部系统的兼容性可能有限。且相比专业的GPU,苹果的硬件可能在处理极其复杂的AI模型时有性能瓶颈。

英伟达在AI领域深耕多年,拥有强大的技术积累和广泛的应用生态,这些都是苹果短时间内难以匹敌的。尽管苹果UMA可能在某些方面对英伟达构成挑战,但英伟达的GPU在AI领域依然具有很强的竞争力。

PC业务能救中国市场吗?

黄仁勋在英伟达2024财年第三季度的财报电话中提到,英伟达20-25%的业务来自中国,美国对中国的高端芯片制裁,将会对英伟达造成严重影响。

2023年8月,英国《金融时报》曾报道了一则中国云厂商抢购英伟达高端GPU的新闻,称百度、字节跳动、腾讯和阿里巴巴四家公司合计向英伟达订购了价值50亿美元的AI芯片。而受美国制裁法案的影响,英伟达机会完全无法履行这些订单。

为了保住中国业务,英伟达再度开始积极设计3款”中国特供“芯片。

某国内服务器制造商近期曾向虎嗅透露,芯片限制政策对国内服务器生产没有影响,因为不管英伟达推出什么芯片,服务器要做的只是适配NV-Link。目前搭载新的“中国特供”芯片的服务器已经接受了很多客户的下单,不过受到美国政府加强管制的影响,原本计划2024年1月到货的“中国特供”,现在看肯定要延后了。

有消息称,拜登政府已经开始调查英伟达为中国开发的三款新型AI芯片的具体细节。美国商务部长吉娜·雷蒙多在接受外媒采访时谈道:“我们会检查每一个新芯片的每一个规格,显然是为了确保它不违反出口管制。”

雷蒙多说,英伟达“能够、愿意、也应该向中国出售AI芯片,因为大多数AI芯片将用于商业应用”,但“我们不能允许他们运送最复杂、处理能力最高的AI芯片,这将使中国能够训练他们的前沿模型”。她强调说不能向中国企业出售其最先进的半导体,并表示将不断更新出口管制规则。

美国对中国的芯片封锁,与其说是在制裁中国,倒不如说是在制裁英伟达。

1月7日,美国《华尔街日报》以“英伟达在中国的新困境,客户不想要它的降级芯片”为题,报道了英伟达为应对拜登政府出口限制,向中国出售降级特供版AI芯片,但中国客户不感兴趣的最新困境。

事实上,RTX40系列显卡在中国的销售也未必会一帆风顺,有消息称,目前英伟达在中国可以销售的最高端芯片为RTX 4090D,这款新芯片比RTX4090的性能低了5%左右。英伟达介绍该产品将从2024年1月起陆续在中国上市。

有知情人士向虎嗅透露,为了缓和与中国客户的关系,英伟达在积极开发“中国特供”的同时,也在与中国服务器厂商协商,希望能在中低端服务器,以及PC业务方面做出一些让步,从而在不取消订单的情况下,用其他产品替代已经下单但不能发货的高端芯片产品。

虽然对于中国的AI公司来说,没有全面封锁GPU芯片就等于断了AI研发的电。但这对中国的芯片企业来说,或许是一个好消息。