摘 要: 针对目前图像拼接算法存在对于图像配准过程中对应特征点对难以准确匹配的问题,提出了一个通过改进的SURF算法提取图像特征点,然后对得到的特征点进行描述,利用快速RANSAC算法配准图像,最后采用像素加权的方法进行图像融合。实验结果表明,提出的改进SURF方法有效地提高了特征点提取的准确性,去除了错误的匹配点对,将整个拼接过程的效率从之前的13.03对/秒提升到15.20对/秒。

关键词: 特征提取;图像拼接;SURF;对称性

0 引言

在日常生活中人们往往需要一幅大范围的全景图像,以此来获得更多的信息。然而,由于镜头拍摄角度的局限性,一般只能得到局部的图像,而全景成像的硬件设备一般比较昂贵。所以,人们就想利用多幅图像拼接成一幅大的图像,这样就可以获取宽视角、高分辨率的全景图像。图像拼接本质上是对待拼接图像的重叠部分进行图像配准和图像融合,其一般步骤是:(1)获取图像序列;(2)图像预处理,去除噪声和图像畸变校正;(3)图像配准,用算法对图像进行配准定位,是图像拼接的关键步骤;(4)图像融合,消除拼接的接缝;(5)输出拼接完成的图像[1-2]。

当前图像拼接的方法主要是包括基于区域的方法和基于特征的方法。基于区域的方法应用重叠区域的所有信息进行计算,因此,它的精度比较高。但是,该方法要使用大量的像素信息,因此计算量很大,并且对光照很敏感[1]。而基于特征的方法则是利用两幅图像重叠区域的点、线或者其他的特征信息来估算两幅图像的对应关系。目前,基于不变特征的物体匹配、识别的研究比较多,比如SIFT算法和SURF算法[3-4]。这些不变特征对于尺度、旋转、光照都具有很高的鲁棒性。对于SIFT算法,其特征描述向量维度(128维)较高,计算量较大[5]。而SURF算法是一种快速鲁棒性算法,其特征描述向量维度(64)也相对较高[6]。针对特征描述符维度高、计算量大的情况,本文提出了一种改进的SURF算法。该方法主要是将对称性得分加入到SURF算法的框架中,其中对称性得分就是指每个特征点和其邻域内点的像素值之差求和。用对称性得分的最小值来表示特征描述符,降低了特征描述的维度,提高了算法的效率。通过对采用算法改进前后特征点对匹配结果进行的对比实验,从特征点对提取数量、时间、匹配率验证了本算法的正确性。

1 SURF算法的介绍及其改进

1.1 特征点的提取与匹配

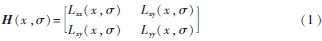

基于特征的图像拼接算法对于特征点提取的效率和精确度要求比较高。传统SURF算法使用64维的特征向量作为后期进行特征匹配的向量,虽然比SIFT算法计算量小、速度快,但是计算效率还不是很高,并且对于特征点的提取精确度不高降低了图像拼接的效率。所以,本文提出了一种改进的SURF算法,使用局部对称性来表示特征向量,而对称性具有尺度、旋转和光照的不变特性。首先,根据Hessian矩阵求出图像的SURF特征点:

其中,是二阶高斯导数g与图像在p点处的卷积,由上式可以得到Hessian矩阵的行列式如式(2)所示。

det(H)=LxxLyy-L2xy(2)

通过Hessian矩阵行列式的计算可以初步得到SURF算法的特征点。

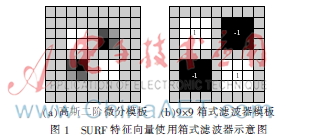

对于SURF特征向量使用箱式滤波器(如图1所示)近似代替二阶高斯导数,用积分图像来加速卷积运算,因此提高了Hessian矩阵的计算效率[6-7]。实验中使用9×9的箱式滤波器来提取局部最大值[8],因此,式(2)可以写成:

det(Happrox)=Dxx×Dyy-(0.9Dxy)2(3)

其中,Dxx、Dxy、Dyy、Dxy分别近似代替Lxx、Lyy、Lxy。如果det为负值,并且特征值是异号,那该点就不是局部极值点;如果det为正值,并且特征值同号,则该点为局部极值点。

其次,当提取到SURF特征点后,就需要对特征点进行特征向量的描述,以便于后期的特征匹配。对于局部图像区域中的任意一点p(x,y),如果关于一条直线是满足轴对称,则可以得到如下公式:

I(x+x′,y)=I(x-x′,y)

I(x,y+y′)=I(x,y-y′)(4)

其中,x′和y′表示点p到对称轴的距离。为了计算对称性得分,定义一个函数Mp,q(q),它表示图像上的点q(x,y)关于对称轴的对应点p(x,y)。如果对于图像上p点的局部区域表现出轴对称的属性,就会有I(q)=I(Mp,q(q))。

以p点为圆心,6 s(s代表当前图像尺度)为半径定义一个圆,则对于点p和其邻域范围内的任意一点之间的图像强度差异函数可以定义为:

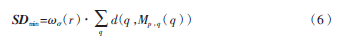

d(p,q)=|I(p)-I(q)|(5)

接下来,使用高斯模板来定义一个权重函数(r),它决定了p点周围的邻域点对对称性得分的贡献值。其中,r代表邻域点到p点的距离,代表权重模板的尺度[9]。最后,计算60°区域的扇形窗口内所有点的距离,使用最小距离SD作为一个向量:

最后,以p点为中心定义一个边长为20 s的正方形区域,将它进一步分成4×4的子区域,对于每一个子区域计算它在5 s尺度的最小距离SD。因此,对于4×4的子区域,最终将形成16维的特征向量。在匹配阶段,使用欧式距离来求取两个特征向量的相似度。一个n维的欧式距离函数表示如下:

其中,xi1表示第一个点的第i维的坐标,xi2表示第二个点的第i维坐标,i=1,2,…16。

当计算出的阈值接近之前设定的阈值,就可以得到两个点匹配。由于这个向量是16维的,最多只需要计SDmin16次,因此整个匹配的速度与原始SURF算法相比有了提升。

1.2 图像拼接和融合

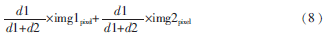

通过提取到的特征点对,计算出两幅图像对应的单应性矩阵。把输入图像按照单应性矩阵映射到参考图像中,就完成了图像的拼接[10]。对于图像融合采取最基本的取两张图像的平均值,但是这样会有明显的拼接缝[11]。使用如下公式计算重叠区域的像素值:

其中,d1、d2分别代表重叠区域中的点到重叠区域左边界和右边界的距离,img1pixel、img2pixel分别代表重叠区域左边图像和右边图像的对应像素点的像素值。经过式(8)的计算,就可以实现平滑过渡。

2 实验结果及结论

本实验是在Win XP、主频1.83 GHz、CPU和内存 1 GB的主机上运行的,使用VS2008+OpenCV来实现图像拼接算法。实验中的图像尺度大小为640×480。本次实验用来验证算法改进前后特征点对匹配的情况,如图2、图3所示。

图2、图3中,图(a)表示从图像中提取的待匹配的特征点,而图(b)表示两幅图像对应的特征点匹配对。从图2和图3的对比实验来看,图2原始SURF算法提取的特征点对相比图3改进后的SURF算法要多,但是原始算法提取的特征点对存在错误的匹配对,而且从特征点对提取的效率来看,原始SURF算法要比改进后的SURF算法低,如表1所示。

最终,图像的拼接结果如图4所示。

3 结论

本文主要是对原始SURF算法在特征提取阶段采用对称性的特征,这种对称性具有旋转、尺度不变性,对光照也有很强的鲁棒性。从实验结果来看,本文算法将提取的特征点对数目从132对减少到71对,相应的特征匹配时间从10.13 s减少到4.67 s,而算法的效率从13.03对/秒提高到15.20对/秒。因此,实验结果表明,文中提出的方法有效地提高了特征点提取的准确性和整个拼接过程的效率。

参考文献

[1] 徐正光,田清,张利欣.图像拼接方法探讨[J].微计算机信息,2006,22(30):255-256.

[2] MATTHEW B, DAVID G. L. Automatic panoramic image stitching using invariant features[J]. International Journal of Computer Vision, 2007:59-73.

[3] 郑海珍.图像拼接技术的研究与应用[D].杭州:杭州电子科技大学,2009.

[4] 蔡丽欢,廖英豪,郭东辉.图像拼接方法及其关键技术研究[J].计算机技术与发展,2008,18(3):1-5.

[5] Jing Xing, Miao Zhenjiang. An improved algorithm on image stitching based on SIFT features[C]. ICICIC′07, Second Internation Conference on Innovative Computing, Information and Control, 2007:453-456.

[6] BAY H, TUYTELAARS T, VAN GOOL L. SURF: speeded up robust features[C]. European Conference on computer Vision, 2006:404-417.

[7] 周军太,龙永红.一种改进SURF算法的图像配准[J].湖南工业大学学报,2011,25(2):95-99.

[8] PARK H, MITSUMINE H, FUJII M. Fast detection of features by reducing the number of box filtering in SURF[C]. IEICE ransactions on Information and Systems, 2011,725-728.

[9] HAUAGGE D C, SNAVELY N. Image matching using local symmetry features[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2012:206-213.

[10] Yi Zhuang, Hu Xinrong, Wang Jianchun. The implenment of an image stitching algorithm based on feature extraction[C]. International Conference on Education Technology and Training, 2009:327-330.

[11] 李柏林.基于特征点图像拼接的配准算法研究[D].天津:天津大学,2008.