吴世东

(中国科学技术大学 自动化系,安徽 合肥 230027)

摘要:针对运动目标跟踪过程中出现的遮挡问题,提出了基于目标先验信息的视觉显著性遮挡目标跟踪算法。在粒子滤波框架下,利用目标先验信息生成视觉显著图,并根据粒子区域颜色特征与目标颜色特征模板之间的相似度来判断遮挡情况。当遮挡发生时,提高特征融合公式中显著性特征的融合权重,从而充分利用目标未被遮挡部分信息来完成跟踪。实验结果表明,利用目标先验信息的目标跟踪算法能显著提升跟踪遮挡目标的鲁棒性。

关键词:目标跟踪;先验信息;粒子滤波;显著性特征

0引言

目标跟踪是计算机视觉领域的重要组成部分,其相关研究成果在三维重构、人脸识别和视频监控等诸多方面均有广泛的应用[12]。在目标跟踪过程中,面临着复杂环境和目标自身因素的干扰,其中目标局部或全局遮挡对跟踪鲁棒性造成了极大的挑战。粒子滤波算法[34]是基于贝叶斯滤波和蒙特卡罗模拟的跟踪算法,在目标跟踪中应用非常广泛。

参考文献[56]根据跟踪过程中不同的遮挡情况,提出了遮挡类型的判别方法,通过设定阈值的方式来对遮档情况进行判断,在不同的情况下使用不同的跟踪算法,提高了解决遮挡问题的能力。

ADAM A等人[7]在2005年CVPR上提出一种基于目标分块的遮挡目标跟踪算法。该算法将目标区域分成许多矩形小块,以此来构造目标特征模板,然后根据目标平滑运动的假设,在目标可能出现的区域检测目标,匹配度最高的像素点位置作为跟踪结果。该算法虽然在一定程度上解决了遮挡问题,但是当目标在跟踪过程中遮挡程度较大时,跟踪精度不高。

赵宇宙等人[8]模拟人类视觉中的关注机制,将视觉显著性应用到目标跟踪算法中。该方法利用相关对比算法提取目标区域中与背景差异较大的小块,用于建立目标模板,然后利用每个小块与目标整体之间的空间映射关系来定位出目标。该算法由于利用了目标局部有效信息,在一定程度上抑制了遮挡对跟踪鲁棒性的影响。

1粒子滤波算法简介

蒙特卡罗模拟和贝叶斯滤波是粒子滤波算法的两个核心组成部分。其大致思想是根据对系统状态的观测结果Zt={z0,z1,…zt}来推测出系统的后验概率分布函数p(xt|z1:t)。根据蒙特卡罗方法,用有限样本点的求和运算来代替积分运算,从而得到目标状态xt。

根据贝叶斯滤波原理,滤波过程分为状态预测和状态更新两个方面。其中,预测是指在不知道目标状态的情况下,用上一时刻的跟踪结果来推测出当前时刻目标的大致位置;更新是指用当前时刻的观测结果Zt来对预测结果进行修正,得到系统后验概率分布函数p(xt|z1:t)。

为方便计算,用带权重的粒子集{xi0:t,wit}N1来近似表示系统概率分布,其中前者为粒子状态,后者为粒子权重。为了方便计算,根据蒙特卡罗方法,可以用有限样本点的加权求和来表示目标状态,其公式为:

式中,xt即为最终跟踪结果。

2显著性检测算法

2.1算法计算过程

近年来,视觉显著性[9]获得了广泛关注,出现了很多视觉显著性检测算法[1012]。视觉显著性机制就是模拟人类视觉特性,从海量的视觉信息当中筛选出有用的信息,提高图像处理效率。

选取颜色特征来表征目标,为了提高颜色特征对于目标与背景的区分能力,对目标区域的特征提取是在HSV颜色空间中完成的。

根据目标运动平滑假设,利用二阶自回归模型预测出目标大致位置:

xt=2xt-1-xt-2(2)

其中,记xt=[x,y,s]表示目标中心位置坐标和尺度信息。提取出目标区域H通道颜色直方图,记为Ht={h1,h2,…,hCmax},其中Cmax为H通道bin个数。

将包含目标先验信息的目标区域颜色直方图Ht在整个图片中反向投影,得到视觉显著图SAL,该过程用公式表示为:

SAL(m,n)=255·hμ,ifc(m,n)∈μ(3)

2.2算法实验结果

图1为用本文基于目标先验信息的视觉显著性检测算法得到的检测结果。

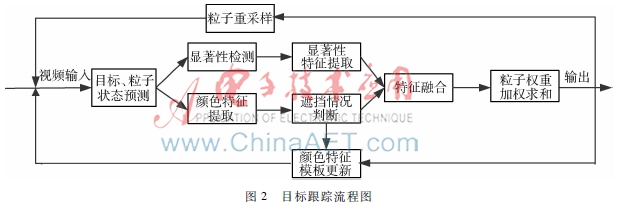

图2目标跟踪流程图从图1可以看出,在跟踪过程当中,目标发生了严重的自遮挡现象,但这不影响目标区域在显著图中的显著度,从而为跟踪鲁棒性打下了基础。

3目标跟踪算法

3.1特征提取

根据上节所述,用上节所述方法对序列图片进行显著性检测,得到显著图SAL。定义视觉显著性特征观测概率为:

p(yst|xit)=1st∑(m,n)∈sitSAL(m,n)(4)

其中,sit为第i个粒子所在的区域范围,st为归一化参数。

颜色特征的提取是在更接近人类视觉特性的HSV颜色空间中完成的,假设颜色特征观测概率为ρ(Hit,Hct)=∑Γμ=1qμpμi,其中,Hit、Hct分别为粒子区间和颜色特征模板直方图,颜色特征观测概率实为它们之间的相似度计算结果。

3.2遮挡判断和特征融合机制

对N个粒子的颜色特征观测概率进行排序,选取观测概率值较大的前一半个粒子作为衡量模板形变大小的参数,可令ζ=2N∑N/2i=1p(yct|xit)作为遮挡判断参数。这样目标是否发生遮挡用式(5)进行判断:

其中,为1则表示发生遮挡,为0则未遮挡。

用颜色特征和视觉显著性特征进行融合跟踪,特征融合方法采用常用的加性机制,定义融合之后的特征观测概率如下:

参数γ根据是否发生遮挡来给出不同取值,其与遮挡参数之间的关系如下:

当未发生遮挡时,颜色特征在融合特征中起主要作用,当发生遮挡时,由于目标被遮挡区域信息丢失,颜色特征可靠性降低,此时主要利用视觉显著性特征来完成跟踪。

3.3目标跟踪算法

目标跟踪整体流程如图2所示。

具体算法流程如下:

(1)目标初始化;

(2)状态预测和显著性检测:

(a)利用式(2)进行目标和粒子状态预测;

(b)利用本文方法对原始图像进行显著性检测,得到显著图SAL;

(3)特征融合和粒子权重计算:

(a)利用式(5)计算出目标状态判断参数Qt,并判断是否发生遮挡;

(b)利用公式(6)进行特征融合,得到融合后观测概率;

(c)粒子权重计算公式为:

(4)是最后一帧,否则返回步骤(2)。

4实验结果与分析

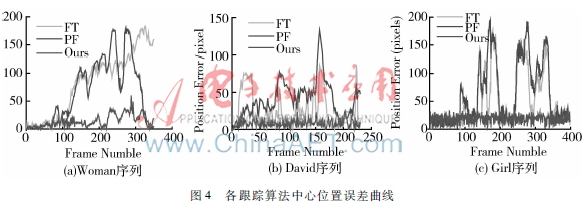

图4各跟踪算法中心位置误差曲线为验证本文算法的跟踪鲁棒性,选取了3个具有针对性的视频序列进行测试,重点考察了目标自遮挡和被静止障碍物遮挡下的跟踪结果,以及分析在跟踪过程中视觉显著性特征所起的作用,并将其与一些经典算法进行了对比实验,如PF[3]、FT[7]。

实验结果如图3所示,各个序列的ground truth由视频的提供者给出。

实验1针对被静止障碍物遮挡的目标进行跟踪,从图中可以看出,本文跟踪算法取得了最好的跟踪结果。其中,FT算法采用固定分块的跟踪方法对目标模板精度要求太高,其跟踪误差会随着时间的推移被逐渐放大;采用单一颜色特征进行跟踪的PF算法虽然能应对一定程度的遮挡,但是当遮挡程度过大时,将会发生跟踪漂移现象;本文采用的基于目标先验信息的视觉显著性跟踪算法取得了不错的跟踪精度,这是因为本文算法能够在遮挡发生时,利用显著性检测算法检测出目标未被遮挡部分区域,然后让鲁棒性更强的显著性特征再完成跟踪。

实验2和实验3针对发生自遮挡的目标进行跟踪,本文算法依然表现良好。从图3可以直观看出,当目标发生自遮挡时,目标的表观颜色发生了剧烈的变化,这导致采用单一颜色特征进行跟踪的FT算法和PF算法无法适应,最终影响了它们的跟踪精度。本文算法在目标发生自遮挡的过程中,由于显著性检测过程融入了目标先验信息,从而实现了鲁棒跟踪。

图4为各跟踪算法中心位置误差曲线图。从图4可以看出,本文算法取得了较好的跟踪效果,跟踪误差一直稳定在一个较小的范围里面,这主要得益于以下两点:一是本文提出显著性检测算法在跟踪过程中融入了目标先验信息,从而使得目标区域显著度较高,提高了显著性特征对目标的表达能力;二是本文采用的遮挡判断方法和特征融合算法能够根据遮挡情况来自适应地选择跟踪策略,提升了算法应对遮挡问题的能力。

5结论

为应对跟踪过程中的遮挡问题,本文对遮挡类型做了详细的说明和分析,并在此基础上构建了基于目标先验信息的视觉显著性检测和跟踪算法。本文跟踪算法通过视觉显著性特征可以对该部分信息进行充分利用,从而避免了跟踪失败;当目标发生了一定程度的自遮挡时,显著性特征能够先于颜色特征做出反应,使得目标区域在显著图中的显著度依然较高,从而为实现鲁棒跟踪奠定了基础。

参考文献

[1] 任加勒, 孟利民. 基于数字喷泉码的视频监控系统研究[J]. 微型机与应用, 2015,34(10): 4447.

[2] 陈娴, 彭宏, 吴海巍,等.视频监控在高速路作业调度系统上的应用[J]. 微型机与应用, 2015, 34(1): 2022.

[3] PEREZ P, HUE C, VERMAAK J, et al. Colorbased probabilistic tracking[C] the 7th European Conference on Computer Vision. Copenhagen: Springer Berlin Heidelberg, 2002: 661675.

[4] 牛德智,陈长兴,班斐,等. 基于变步长重采样的非高斯非线性目标跟踪[J].电子技术应用, 2014, 40(8): 129132.

[5] SAKARI V, SETHI I K. Feature point correspondence in the presence of occlusion[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1990, 12(1): 8791.

[6] RANGARAJAN K, SHAH M. Establishing motion correspondence[C] IEEE Conference on Computer Vision and Pattern Recognition, 1991: 103108.

[7] ADAM A, RIVLIN E, SHIMSHONI I. Robust fragmentsbased tracking using the integral histogram[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2006:798805.

[8] 赵宇宙, 陈宗海, 显著子区域在线选择的目标鲁邦跟踪[J]. 控制与决策, 2014, 29(10): 17881792.

[9] BORJI A, ITTI L. Stateoftheart in visual attention modeling[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(1): 185207.

[10] ITTI L, KOCH C, NIEBUR E. A model of saliencybased visual attention for rapid sceneanalysis[J]. IEEE Transactionson Pattern Analysis and Machine Intelligence, 1998, 20(11): 12541259.

[11] Cheng Mingming, Zhang Guoxin, MITRA N J, et al. Global contrast based salient region detection[C] IEEE Conference on Computer Vision and Pattern Recognition, 2011: 409416.

[12] 钱生, 林明强, 陈宗海, 等, 基于条件随机场和图像分割的显著性检测[J]. 自动化学报, 2015, 41(4): 711724.