潘峰

(国家税务总局税务干部进修学院,江苏 扬州 225007)

摘要:随着终身学习体系的逐步构建,基于互联网的远程学习模式应用不断普及,各种网络学习平台也不断累积大量的学员学习和考试方面的数据。采用数据挖掘技术对这些数据进行分析,可以充分挖掘网络学习平台存量数据的价值。基于C5.0决策树算法,采用软件工具对研究数据进行分析,发现了影响考试结果的诸多因素及其重要性,可以针对如何改善学习方法、提升学习效果、改善平台的服务模式等提出很好的改进建议。

关键词:决策树;考试结果;预测

1网络学习与考试

基于Internet的网络学习是目前比较流行的远程学习模式,它打破了传统学习的时空环境限制,有利于构建终身学习体系。网络学习平台的学习内容以Web页面的形式呈现,具有费用低廉、资源更新快、交互性强等特点,学员可以随时随地安排自己的学习时间,提高学习效率。

网络学习平台除了提供在线学习功能,往往还提供随堂练习、课程作业、课程考试等考试功能。对学习者学习状况的评估将直接影响他们对网络学习的态度、积极性和效果[1]。“学而时习之”,通过网络学习平台的考试功能进行自我练习(考试)、参加有组织的考试可以有效促进学员学习,提高学习效果和针对性。

2决策树与C5.0算法

决策树的分析结果形似一棵倒置的树,所以称为决策树。决策树算法是一种逼近离散函数值的方法[2],它通过构造决策树来发现数据中蕴涵的分类规则。决策树构造的输入是一组带有类别标记的例子,构造的结果是一棵二叉树或多叉树[3],由上到下依次为根节点、内部节点和叶节点。决策树通过对训练样本的学习建立分类规则,依据此规则实现对新样本的分类,属于有监督的学习方法[4]。

决策树的类别包括分类决策树和回归决策树,其中,分类决策树目标变量为分类型数值,其输出变量的众数就是分类结果。决策树的分类过程是基于逻辑的,每一个叶节点都对应于一条布尔规则。树的生长过程(即建立决策树的过程)就是把数据不断进行切分的过程,每一次切分力求分成的各组之间的差异最明显。各种决策树算法使用了不同的剪枝策略,它们的主要区别是对这种“差异”明显程度的衡量方式。

决策树的构建过程是一个递归的过程,所以需要确定停止条件。最直观的方式是当每个子节点只有一种类型的记录时停止,但往往会导致过度拟合(树的节点太多)。另一种方法是设置当前节点中的记录数最小阈值,将置信度最大的分类作为当前叶节点的分类。

作为一种分类决策树模型算法,C5.0可以生成决策树或规则集。C5.0算法基于信息增益度分裂方式,第一次拆分确定样本子集,然后根据另一个字段再次拆分,这一过程重复进行直到样本子集不能被拆分为止[4]。C5.0算法以信息熵的下降速度(能够带来最大信息增益的变量)作为确定最佳分支变量和分割阈值的依据。熵是对样本不确定性的一种度量[5]。一个系统越是有序,信息熵就越低;反之,一个系统越是混乱,信息熵就越高。

3C5.0决策树算法在考试结果预测中的应用

3.1数据挖掘工具

SPSS Clementine是SPSS公司收购取得的数据挖掘工具。SPSS Clementine 12.0结合商业技术可以快速建立预测性模型,帮助用户改进决策过程。Clementine广泛支持Kmeans模型、C5.0决策树、神经网络等各种预测模型。

3.2数据准备

本文研究的数据对象为某网络学习平台导出的2015年课程学习和课程考试情况数据(学员学习课程与考试结果);数据格式为“课程学习与考试情况”Excel表;操作系统采用Windows 7 Professional 32 bit;硬件配置:内存为4 GB。

该学习平台目前拥有注册学员近2 000人,提供标准格式课件点播服务,还提供课程同步模拟考试服务。“课程学习与考试情况”表记录了用户学习过的课程的次数、时间,还记录了该课程同步模拟考试的结果,具体字段为“所属部门”、“用户名”、“姓名”、“课程名称”、“考核状况”、“学习次数”、“学习总时长”,记录共有18 476条。部分示例如表1所示。

3.3数据处理

通过对数据格式和内容的调整、完善,可以使得建立的模型更简单、准确[6]。

为了构造新的衍生特征信息,这里增加一个输入字段,使用WPS 表格10.1软件增加“次平均学习时长”列,列值为使用公式计算学习总时长/学习次数的结果。

由于直接使用表格文件,这里无需添加本地数据源,在Clementine软件中直接添加Excel“源”节点,命名为“学习考核情况”,导入对应的数据文件和工作表。在“过滤”中配置字段筛选,缩小处理范围,清除无用字段(如“所属部门”、“用户名”、“姓名”字段),如图1所示。预处理后的总数据记录数不变(图1字段过滤数据格式如表2所示)。添加“类型”节点设置各字段“数据类型”和“方向”,“考核状况”对应“标志”类型,“学习次数”对应“集”类型,“次平均学习时长”对应“范围”类型,如图2所示。

通过“重新分类”节点对学习次数进行规范化分类,这里根据数据密度分为“1+”、“5+”、“10+”、“30+”,分别代表1≤学习次数图2数据类型≤4、5≤学习次数≤9、10≤学习次数≤29、学习次数≧30,生成新字段名“学习总次数分段”。

3.4利用C5.0决策树算法进行数据挖掘

继续添加一个C5.0节点,对数据进行挖掘,配置目标字段“考核情况”,输入字段为“学习总次数分段”、“次平均学习时长”,“模型”中配置选择使用分区数据,输出类型为“决策树”,选择“组符号”(使用分箱法检查当前分组变量的各类别能否合并,如果可以先合并再分枝,此方法得到的决策树相对精简),修剪严重性(置信度)设置为75%,子分支最小记录数为200。

Clementine从读入数据到结果显示的数据挖掘全过程,是以流程图的形式显示在数据流程区内的,如图3所示。每个节点规定了数据的不同操作,箭头表示数据流向,各种操作组合起来就形成了通向目标的路径。将前面的节点相连接,执行结果“考核结果”会出现在软件主界面右上角管理器“模型”中,浏览这个模型可以看到数据图3Clementine数据流程区

挖掘结果。需要注意的是,可以对各节点添加输出节点“表”观察各节点数据情况(可以将模型结果添加进数据流程区并输出)。

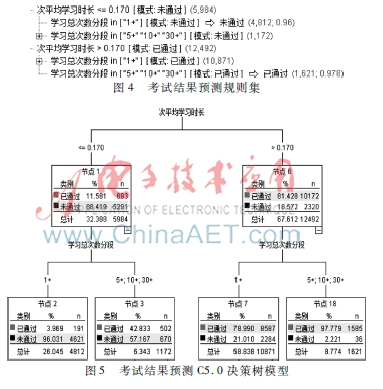

针对实验数据执行决策树模型“考核结果”,生成规则集(如图4所示)和决策树模型(如图5所示)。

3.5考试结果预测模型解读

次平均学习时长≤0.17小时的学员,“未通过”考试的可能性为88.4%;次平均学习时长>0.17小时的学员,通过考试的可能性为81.4%。次平均学习时长≦0.17小时且学习次数低于5次的学员,“未通过”考试的可能性为96%;次平均学习时长>0.17小时且学习次数超过5次的学员,通过考试的可能性为97.8%。在决定考试是否通过的因素中,“次平均学习时长”最重要,其次是“学习次数”。从实际经验角度看,每次学习时间较长且学习次数较多的学员,通过考试的概率可能会较大。根据该网络学习平台的课程学习和考试数据,并使用较为先进的Clementine数据挖掘软件构建的C5.0决策树模型,量化反映了网络学习和考试的这一现象;又由于软件建模时采用分区数据,提高了模型在不同样本集上的稳健性,因此获得的预测模式较为可信。

各类网络学习平台可以参考此模型更好地指导学员在线学习,有针对性地提出学习建议,如提醒学员上网学习和学习次数等;也可以进一步针对学员进行聚类分析,深度定制课件资源和服务内容,如开发移动客户端,提高用户访问平台的便捷性等。

4结论

随着网络学习平台的发展和提升,为更好地贴近用户需求,深化学习效果,应当关注业务提升需求,充分挖掘海量的学习和考试数据,研究并发现决定学习效果的关键因素。C5.0算法在面对输入字段较多的问题时比较稳健,也易于理解,同时也擅长处理非数值型数据,可以在网络学习平台关键问题预测中发挥更大的作用。

参考文献

[1] 岳伟.建构主义学习理论指导下的自学考试网络助学策略设计[J].考试研究,2015(1):915.

[2] 张军.数据挖掘中自我学习算法研究[J].网络安全技术与应用,2014(11):171,173.

[3] 陈承斌.基于决策树算法分析恶意网络攻击和入侵[J].信息与电脑(理论版),2010(7):15.

[4] 陈春茶.数据挖掘技术在移动商务客户价值识别中的应用研究[D].昆明:云南大学,2012.

[5] 宋海霞,严馨,于正涛,等.基于半监督主动学习的虚假评论检测[J].昆明理工大学学报(自然科学版),2015,40(5):5965.

[6] 张线媚.数据挖掘在电信行业客户流失预测中的应用[J].微型机与应用,2015,34(15):99102.