文献标识码:A

DOI: 10.19358/j.issn.2096-5133.2018.07.014

中文引用格式:吴乾绅.融合多视角信息的RGB-D图像协同显著性检测[J].信息技术与网络安全,2018,37(7):58-61,66.

0 引言

图像的显著性[1]概念是人类在研究视觉感知机制的过程中提出来的,可以理解为视觉场景中物体吸引人类注意力的程度。近年来,图像显著性检测研究受到了广泛关注,并在物体识别、图像检索等领域展现出广阔的应用前景。早期的工作主要基于人工设计的视觉特征进行显著性检测,例如对比算法[1]以及多尺度显著区域融合[2]等。近年来,深度学习被逐渐用于图像显著性检测,并取得了良好的实验效果[3]。随着深度相机的普及,深度图像(RGB-D图像)的数据规模呈爆炸式增长,而且能克服二维图像丢失深度信息的不足,因此利用深度信息提升视觉分析性能逐渐成为计算机视觉领域新的趋势,吸引了研究人员的关注。在已有研究中,文献[4]融合了深度信息来检测图像中的显著目标,文献[5]采用了一种进化策略检测RGB-D图像中的显著区域。以上工作均局限于检测单幅图像的显著性,难以用于检测一组相关图像的协同显著性。

较之单幅图像显著性检测,图像协同显著性检测力求在一组内容相关的图片中发现共有的显著目标。理论上,互相关联的图片组包含了更多信息,而且重复出现的目标有助于进一步理解图像。对于RGB图像,文献[6]通过采用3个自下而上的显著特征(对比特征、空间特征以及相似特征)进行特征聚类来获得协同显著图。文献[7]提出了一个基于多层分割的算法模型,该算法在粗分割的基础上确定目标轮廓,然后通过细分割检测区域间的相似性。文献[8]通过基于图模型的流行排序算法获得协同显著图,但是仅使用单一图模型必然会丢失部分信息。近年来,探索RGB-D图像的协同显著性也逐渐成为研究热潮。与以往的前向检测策略不同,文献[9]设计了一个反馈迭代优化模型来检测协同显著目标。文献[10]通过特征匹配约束和显著性标记传播实现对RGB-D图像的协同显著性检测。可以看到这些方法依赖于算法中所设计的自下而上的先验特征,而且并没有充分利用单幅图像的显著信息,因此在检测效果上仍有很大的提升空间。

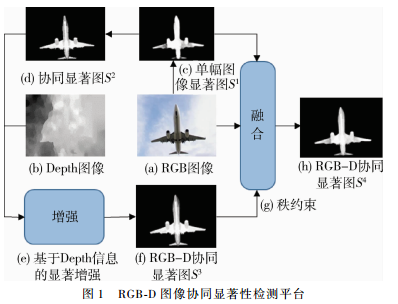

为了克服上述不足,本文提出了一种基于多视角信息融合的RGB-D图像协同显著性检测算法。如图1所示,考虑到单幅图像的显著图包含了大量的图像前景区域信息,本文首先采用深度学习网络获得效果良好的单幅RGB图像的显著图。接着,提取图像的多种类型特征建立多图模型,采用流形排序算法初步检测到协同显著性目标。然后使用基于深度信息的显著图对初始的协同显著图进行优化,最后使用秩约束算法将多种显著信息进行融合,在进一步增强目标显著性的同时降低了非显著区域的影响。在标准数据集上的检测结果证明了本文方法的优越性能。

1 RGB-D图像的协同显著性检测

1.1 基于DHSNet的单幅图像显著性检测

深度学习诞生以后,研究人员提出了各种模型来进行显著性检测。尽管一些卷积网络在检测效果上取得了长足进步,但仍然可能存在以下不足:(1)没有优先考虑全局特征;(2)单独处理超像素等局部区域时,并没有在映射空间中充分利用它们之间的关联信息。深度层次神经网络(Deep Hierarchical Saliency Network,DHSNet)[3]很好地克服了这些不足,它采用先卷积而后逐步细化微调的方式不断优化显著性检测结果。因此,给定RGB图像集 ,采用DHSNet来获得效果良好的单幅图像的显著图

,采用DHSNet来获得效果良好的单幅图像的显著图 。

。

1.2 基于多视角信息融合的图像协同显著性检测算法

(1)多图模型

仅依赖于单一图模型的检测算法[8]不可避免地会丢失部分重要的图像信息,因此本文提出了一种基于多视角信息融合的协同显著性检测算法,通过多种图像特征建立多图模型[11]来检测协同显著目标。给定RGB图像集 及属于Ii的超像素[6]的集合Ωi=

及属于Ii的超像素[6]的集合Ωi= ,首先抽取共G种类型的图像特征,接着,将任一超像素作为节点V,将节点之间的特征距离作为连接权重建立图模型ζ=(V,W),定义连接权重为:

,首先抽取共G种类型的图像特征,接着,将任一超像素作为节点V,将节点之间的特征距离作为连接权重建立图模型ζ=(V,W),定义连接权重为:

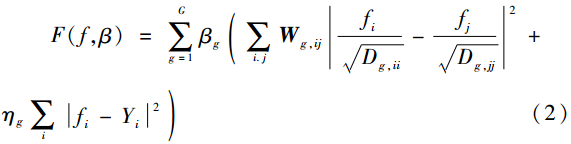

式中xg,j为节点xg,i的近邻节点,g表示某一种图像特征。采用多种类型的图像特征建立多图模型,其损失函数为:

其中矩阵Wg,ij由wg,ij构成且Dg,ii=![]() 。理论上,每个图模型的权重是不同的。引入参数λ获得公式(1)关于f和β的凸模型:

。理论上,每个图模型的权重是不同的。引入参数λ获得公式(1)关于f和β的凸模型:

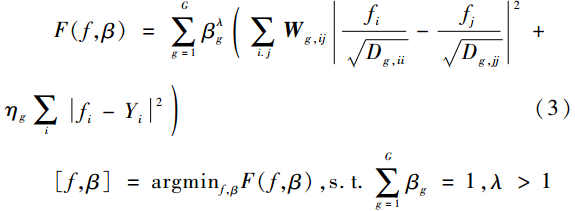

采用迭代的方式对式(3)求解。分别对f以及β求导,有:

固定f求βg:

固定β可以求得f:

其中fT是f的转置矩阵,Lg=D-1/2gWgD-1/2g为相应的拉普拉斯矩阵。

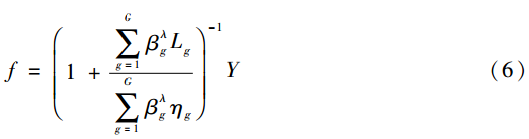

(2)协同显著性检测

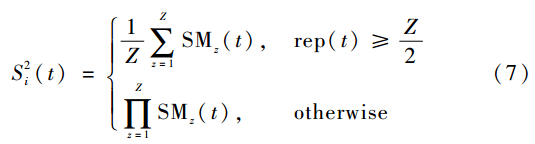

考虑到单幅图像的显著图可以为协同显著目标的检测提供重要的信息,因此采用流行排序算法进行协同显著性检测。给定单幅图像的显著图S1,对于任一包含Z幅图像的图像组,首先根据显著图S1给每张图像赋初始显著值,记为y=[y1,y2,…,yZ],对于任意yk(1≤k≤Z),可以通过协同显著性检测算法公式(6)获得余下的(Z-1)张图像的初始协同显著图,按照相同的方法,对每一张图像轮流进行上述操作。因此对于每幅图像总共可以得到(Z-1)张协同显著图SMZ-1和1张初始的显著图。将Z幅显著图SMZ进行融合获得协同显著图 :

:

其中t表示超像素, rep(·)为在Z个图像中某一超像素被记为显著目标的次数。通过该算法过程,不仅可以在单幅图像显著图的基础上增加未标记的协同显著区域,而且抑制了非协同显著区域。

1.3 基于深度图的显著性检测及融合

对比因子类似于人类视觉系统的感受野,因此对比线索广泛用于显著性度量。对于图像Ii的任一像素点ra,定义特征对比线索[12]为:

![]()

与RGB图一样,深度空间里唯一的距离信息也可以增强目标的显著性。D(ra,rb)为像素ra和rb的深度信息差异,也可以看作是相对显著程度,ω(ra,rb)是空间权重项,分别定义为:

其中,d(ra,rb)是像素ra和rb的欧式空间距离, α2为常数控制空间权重。在视觉注意机制中,人们更倾向于关注图像的中心区域。因此引入空间偏置进行平滑:

![]()

式中第一项反映了中心偏置,la为像素坐标,N是高斯核函数,θ为图像中心,方差σ2为归一化后的图像半径。第二项为深度信息偏置,定义为:

![]()

其中,q=max{da}-min{da},为深度图中距离da最远和最近的像素之间的距离,γ为平衡参数。借助于中心偏置,基于深度图的显著性检测模型可以定义为:

![]()

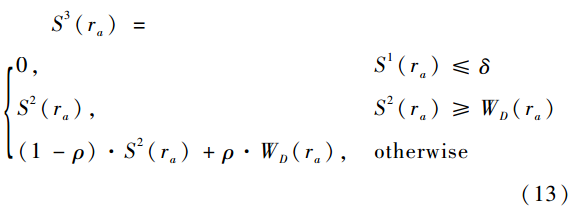

基于深度信息的显著图虽然包含了重要的显著信息,但同时也要进一步去除非协同显著的区域。考虑到单幅图像的显著图S1基本包含了显著区域,首先采用掩码的方式大致剔除非前景区域,然后考虑如下的融合方法:如果协同显著区域的显著值较大则将其保留下来,否则应将其与基于深度信息的显著图进行线性拟合,即:

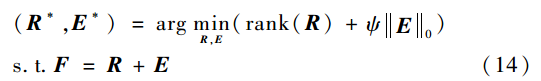

1.4 基于秩约束的融合算法

作为显著性检测研究的发展,协同显著性检测不仅和单幅图像的显著性检测一样遵循视觉显著机制,而且显著目标在多张图片中展现出了较高的相似度和稳定性,在数学矩阵上表现为低秩特征,称之为秩约束[13]。给定图片集 ,通过M个显著性检测方法计算获得N×M显著图。首先通过显著性阈值(设置为0.3)得到图像的前景区域f,然后计算得到1 000维的RGB颜色直方图作为该前景区域的颜色特征,记为F=[f1,f2,…,fM],计算其近似低秩矩阵R:

,通过M个显著性检测方法计算获得N×M显著图。首先通过显著性阈值(设置为0.3)得到图像的前景区域f,然后计算得到1 000维的RGB颜色直方图作为该前景区域的颜色特征,记为F=[f1,f2,…,fM],计算其近似低秩矩阵R:

式中ψ为控制E的稀疏性的权重参数,采用主成分分析算法(RPCA)[14]来解决相应的凸优化问题。理论上,对于所有的输入图像, 其协同显著图通过利用自适应权重融合每个 获得:

获得:

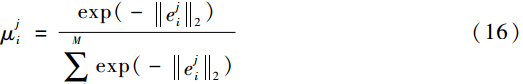

式中 为

为 的权重,满足0≤

的权重,满足0≤ ≤1,且:

≤1,且:

其中 为E*的第i列。当稀疏误差越小时,该区域的协同显著性概率就越大。

为E*的第i列。当稀疏误差越小时,该区域的协同显著性概率就越大。

2 实验结果及分析

2.1 数据集及评价标准

Cosal150数据集目前被广泛用于RGB-D图像协同显著性检测。实验中,令α2=0.4,ηg=0.01,γ=5,ρ=0.5,δ=0.01,σ2=1,ψ=0.05。对于RGB图像分别抽取颜色特征以及纹理特征,同时通过FCN[15]深度网络抽取Conv1_2层特征和Conv5_3层特征,因此G=4。在实验中经过MAE测试令λ=1.2。在秩约束融合过程中,将S1、S2、S3以及通过LI G等[16]设计的深度学习模型获得的单幅图像显著图进行融合。为了定量比较试验效果,采用准确率-召回率(Precision-Recall)曲线和平均绝对误差(MAE)两种评价规则。准确率与召回率曲线是通过改变显著阈值判断像素是否显著获得的。MAE是显著图和真实标注图之间的平均绝对误差,定义为:

其中,S(x,y)为算法预测的显著图,GT(x,y)为标注的真实显著图,W、H分别为图像的宽度和高度。

2.2 效果对比

将本文提出的算法与其他协同显著性检测方法做对比。对于RGB图像,主要与模型CB[6]、HS[7]、SCS[11]进行对比。针对RGB-D图像,主要与代表性的检测模型MFM[10]、IC[9]进行对比。实验结果如图2以及表1所示。可以看到,本文方法在PR曲线上大幅领先其他方法。对于MAE,本文方法取得了最小值0.093,相比MFM下降了32.61%。

2.3 算法分析

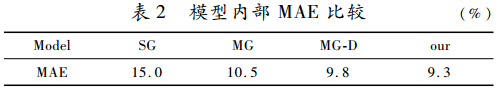

为了证明多图模型以及深度信息的重要作用,对算法模型进行逐步分析。实验结果如图3及表2所示。从PR曲线可以看到在采用多图模型后(MG),检测结果与单图模型[8](SG)相比有显著提升,对应的MAE下降了30.00%。加入深度信息后(MG-D),PR曲线进一步提升,同时MAE相比MG下降了6.67%。进一步地,在采用秩约束算法融合显著信息(our)后,PR曲线达到最优,MAE也获得了最小值0.093,与MG-D相比继续下降了5.10%。该分析实验表明,深度信息在图像协同显著检测中起到巨大作用,同时融合多种显著信息能有效提升检测效果。

3 结论

本文提出了一种基于多视角信息融合的RGB-D图像协同显著性检测算法。该算法通过使用多种类型的图像特征建立多图模型,有效克服了单一图模型在检测过程中的信息丢失问题。实验还表明融合深度信息能有效提升协同显著性检测效果。值得指出的是,本文提出的方法不仅适合RGB-D图像协同显著性检测任务,也同样适用于RGB图像的协同显著性检测。接下来的工作将更好地融合深度特征以及采用深度学习方法进行RGB-D图像的协同显著性检测。

参考文献

[1] KOCH C, ULLMAN S. Shifts in selective visual attention: towards the underlying neural circuitry[M].Matters of Intelligence, Springer Netheriands, 1987.

[2] TONG N, LU H, ZHANG L, et al. Saliency detection with multi-scale superpixels[J]. IEEE Signal Processing Letters, 2014, 21(9): 1035-1039.

[3] LIU N, HAN J. DHSNet: deep hierarchical saliency network for salient object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 678-686.

[4] Cong Runmin, Lei Jianjun, Zhang Changqing, et al. Saliency detection for stereoscopic images based on depth confidence analysis and multiple cues fusion[J]. IEEE Signal Processing Letters, 2016,23(6):819-823.

[5] GUO J, REN T, BEI J. Salient object detection for RGB-D image via saliency evolution[C]//2016 IEEE International Conference on Multimedia and Expo (ICME). IEEE, 2016: 1-6.

[6] FU H, CAO X, TU Z. Cluster-based co-saliency detection[J]. IEEE Transactions on Image Processing, 2013, 22(10): 3766-3778.

[7] LIU Z, ZOU W, LI L, et al. Co-saliency detection based on hierarchical segmentation[J]. IEEE Signal Processing Letters, 2014, 21(1): 88-92.

[8] LI Y, FU K, LIU Z, et al. Efficient saliency-model-guided visual co-saliency detection[J]. IEEE Signal Processing Letters, 2015, 22(5): 588-592.

[9] CONG R, LEI J, FU H, et al. An iterative co-saliency framework for RGBD images[J]. IEEE Transactions on Cybernetics, 2017(99):1-14.

[10] CONG R, LEI J, FU H, et al. Co-saliency detection for RGBD images based on multi-constraint feature matching and cross label propagation[J]. IEEE Transactions on Image Processing, 2018, 27(2): 568-579.

[11] ZHAO S, YAO H, YANG Y, et al. Affective image retrieval via multi-graph learning[C]//Proceedings of the 22nd ACM International Conference on Multimedia. ACM, 2014: 1025-1028.

[12] LIU T, YUAN Z, SUN J, et al. Learning to detect a salient object[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(2): 353-367.

[13] CAO X, TAO Z, ZHANG B, et al. Self-adaptively weighted co-saliency detection via rank constraint[J]. IEEE Transactions on Image Processing, 2014, 23(9): 4175-4186.

[14] CANDS E J, LI X, MA Y, et al. Robust principal component analysis?[J]. Journal of the ACM (JACM), 2011, 58(3): 11.

[15] LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 3431-3440.

[16] LI G, YU Y. Deep contrast learning for salient object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, 2016: 478-487.

(收稿日期:2018-04-29)

作者简介:

吴乾绅(1990-),男,硕士,主要研究方向:模式识别。