谷歌已经实现“量子霸权”?有争议,不实用,但仍然伟大

2019-11-07

来源:极客网

相信你已经听说谷歌宣称在量子计算方面取得突破,已经实现“量子霸权”。最强超级计算机要10000年完成的计算量,量子计算机只要200秒就能解决。量子计算的厉害之处可见一斑。什么是量子霸权?量子计算为何重要?谷歌量子计算到底发展到什么地步?为什么IBM表示不服?今天就随极客网来探究一番。

什么是量子计算和量子霸权?

在我们的日常生活中,事件的可能性可以用0-100%来划分,没有负值,所以我们不会说有-30%的可能性会下雨。当我们搭建物理块时,比如用电子、光子搭建,它们遵守的可能性原则完全不同,这就涉及到另一个概念“amplitudes”(幅值),这个值有正、有负,甚至有可能更复杂。如果某事件可以以正幅值的形式发生,也可以以负幅值的形式发生,那么它的可能性就会消失,因为总幅值可能是0,事件永远不会发生。就这是所谓的“量子干涉”,量子世界正是根据这样的奇怪规则建立的。

假设有1000个量子比特,它们全都会相互作用,根据量子力学的游戏规则,1000个量子比特的每一种可能搭配方式都会有一个幅值。1000个量子比特能同时处于2种至1000种状态中,约有10的300次方种可能性,而宇宙中只有10的80次方个原子。

传统计算机使用0或者1的比特来存储不同信息,量子计算机使用量子比特存储信息。量子比特存储的信息可能是0、可能是1,也有可能既是0也是1。量子力学认为,一个原子可以同时处于两种状态。1个量子比特可以存储2种状态的信息,也就是0和1;2个量子比特就可以存储4种状态的信息,3个8种,4个16种。

谷歌量子计算机有53个量子比特,有2的53次方种状态,约为9 quadrillion(千万亿,1后面15个0)。科学家相信,用谷歌量子计算机完成计算时,它走1步,传统计算机要走9千万亿步。

那么什么是“量子霸权”呢?其实谷歌管它叫量子优势,不叫量子霸权,指的是量子计算的计算力超越经典计算机。

谷歌真的实现量子霸权了吗?

谷歌宣称已经实现“量子霸权”,全球媒体专家都是怎样看的?我们收集几个媒体的重要观点,让大家深入了解一下,量子计算到底意味着什么?谷歌是否真的实现了量子霸权?

Vox:小块头也有大能力,谷歌量子计算机只有一张床大小

量子霸权这个术语是2012年提出来的,意思就是说量子计算机可以做一些事,但经典计算机跟不上它的速度。简单来说就是量子计算机的计算速度比常规计算机快很多。不过有许多人表示怀疑,认为量子计算机可能无法完成实际计算。

目前世界最快的经典计算机名叫Summit,归IBM所有,它有两个篮球场那么大。谷歌量子计算机很小,可能只有一张床那么大,名叫Sycamore。谷歌给Sycamore一个特殊的问题,让它解决,这个问题叫“随机电路建模”问题。

谷歌声称解决同样的问题经典计算机要1万年,而Sycamore量子计算机只要200秒。IBM表示怀疑,它认为最强大的超级计算机解决此问题只要两天半。

即使是这样,谷歌的成就也不容忽视。经典计算机要两天半解决的问题,量子计算机只要200秒。如果谷歌量子计算机更大一些,有70个量子比特,经典计算机要像它一样强大,体积可能有一个城市那么大。

在量子计算领域,在过去一段时间IBM一直是领先者,它并没有将“量子霸权”当成追求的目标。为什么?因为IBM认为所谓量子霸权只是一个人为设定的基准,即使你跨过了基准线,它可能还是没什么用。

Gizmodo:量子计算也会犯错,对计算环境要求苛刻

尽管谷歌取得技术突破,但量子计算机还是会犯错。与外部世界的任何一点作用都可能会让量子比特出现错误。但谷歌的实验向我们证明,当量子比特越来越多时,人类预测错误的能力也会越来越强。

谷歌科学家Marissa Giustina说:“我们已经证明,我们能够理解这些错误。这是一个重要的工程、物理突破。”

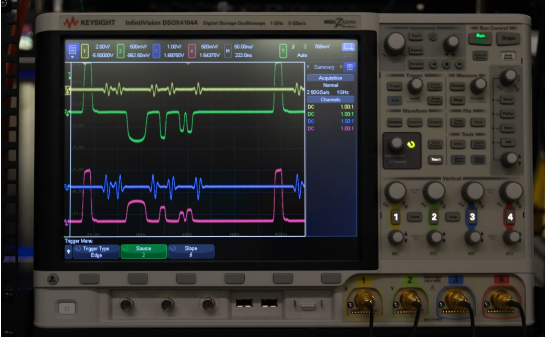

当你接触量子计算程序,你会通过常规计算机界面来操纵,发出脉冲,它可以改变量子比特的赋值,和五线谱上的音符有点像。完成操作后,研究人员向我展示发送的脉冲是怎样的形状。

无论怎样,在科学层面,谷歌已经向我们展示更大、更复杂的量子系统,比之前的量子计算机都要复杂。从计算层面看,我们已经进入陌生领地,在这里量子计算机已经是可见可摸的设备,它能做经典计算机做不了的事。

难怪Marissa Giustina说:“现在我们已经进入计算新领域,通过其它工具你进不了。”

麻省理工技术评论:谷歌与IBM争了起来,后者的经典计算机也很强大

“量子霸权”最初是由加州理工学院科学家John Preskill提出的,他认为,在挑选问题时谷歌的选择面很窄,它选了量子计算机擅长而经典计算机不擅长的问题。John Preskill说:“量子计算几乎没有架构,所以经典计算机很难跟上,正因如此,量子计算提供的答案在信息方面严重不足。”

另外,谷歌在模拟时不能简单将量子计算代码移植到经典计算机上。当模拟的量子比特增加时,难度也会增加,而且是指数级增加。正因如此,才会有各种各样的代码优化技术出现,只有利用这些技术才能获得足够好的结果。

IBM研究人员提出一种方法,用这种方法计算,经典计算机只要两天半就能完成谷歌所说的任务,如果稍作优化,时间会更短。

关键差异在哪里呢?在硬盘。用经典计算机模拟量子计算机,需要处理海量数据。内存如果越小,你就要将任务划成更多的部分,需要的时间也就会更长。谷歌高度依赖RAM,用RAM来存储数据,IBM既用到了RAM,也用到了硬盘。IBM还说可以用其它经典计算机优化技术(硬件和软件技术)来提升速度。IBM虽然给出了方法,但它并没有真正测试,所以我们不能判断效果到底是否真像它说的那样好。

争论真的重要吗?可以说是,也可以说不是。正如Preskill所说的,谷歌解决的问题几乎没有什么实际用处,即使谷歌量子计算机再大一些,解决最狭窄的经典问题时也要很长时间。想用量子计算机破解现代编码,至少还要等几十年。

尽管如此,Preskill还是认为达到“有限量子霸权”仍然重要,它意味着我们离实用量子计算机又近了一些。

彭博社:有突破也有风险,加密技术可能会被瓦解

谷歌量子计算也给我们带来一些风险。首先,全球将量子计算竞赛将会进一步升温,后果无法预测。去年,美国总统特朗普签署一项命令,投入11亿美元,优先发展量子计算技术,这只是开始。如果美国想在量子计算领域继续成为全球领导者,必须做更多事。

还有一个担心,当先进的量子计算机到来时,保护全球数字世界的加密技术可能会被瓦解。这些加密系统以精深的数学问题作为基础,但从理论上说,难题在量子计算机面前形同儿戏。安全研究人员已经意识到问题的存在,他们正在努力开发“后量子”系统和标准。

毫无疑问,量子计算时代会从许多错误、从希望的破灭、从难以克服的困难开始。谷歌已经向我们证明量子计算技术正在进步,以一个量子比特一个量子比特的速度前进,走向奇怪的未来。

世界经济论坛:量子计算应用广阔,前景光明

有了量子计算技术,我们可以构建全新互联网,用量子比特而非比特构建。对于加密通信来说,量子计算技术也很重要,因为量子通道可以让传输变得更安全。

除此之外,量子计算技术还可以用在机器学习领域,相比经典计算机,量子计算机的计算速度更快。有人相信,在未来6-12个月,量子计算就会在“机器学习”领域获得“量子霸权”。

量子计算的应用前景几乎无穷无尽,加密、机器学习、化学、优化、通信等行业都用得上。这还只是开始,研究人员正在努力,看看如何将量子计算与其它行业结合。

谷歌量子计算机解决的问题没有任何实际意义,它只是向我们证明量子计算潜力无限,在未来几年里,人类也许就会解放这种能力。

南华早报:中国量子计算正在追赶美国

2018年,阿里巴巴推出量子计算云,系统装备的量子处理器有11个量子比特,当时它是世界第二快的量子计算机,只比IBM量子计算机(20个量子比特)慢一些。

同样在2018年,百度也建立自己的量子计算研发中心,由教授Duan Runyao主管,他曾说要在2023年之前将百度量子计算机研究院变成世界一流研究院。

另外,中国已经在合肥设立国家量子计算中心。

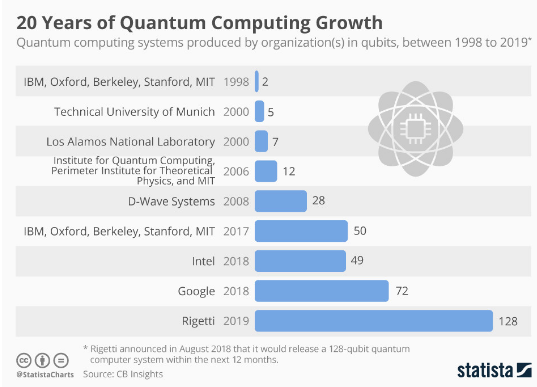

到目前为止,在量子比特的增加上,西方比中国领先。虽然这次谷歌展示的Sycamore有54个量子比特(其中一个没有工作),但去年谷歌曾经说过它开发出72位量子芯片。很快IBM也会向客户开放53位量子计算机。

量子比特的数量代表一切吗?不是的。要让计算任务完美完成,量子比特必须正常运行。在现实状态中,它经常犯错,需要修正,量子比特越多,修正越难。

总之,在量子计算领域,谷歌已经成为第一名,但中国企业正在快速追赶。

以上就是极客网分析解读,并收集整理的一些国外媒体对量子计算及谷歌量子霸权的看法,对此你有什么高见?欢迎与我们分享。